GATE: Um Modelo de Avaliação Integrada do Impacto Econômico da IA

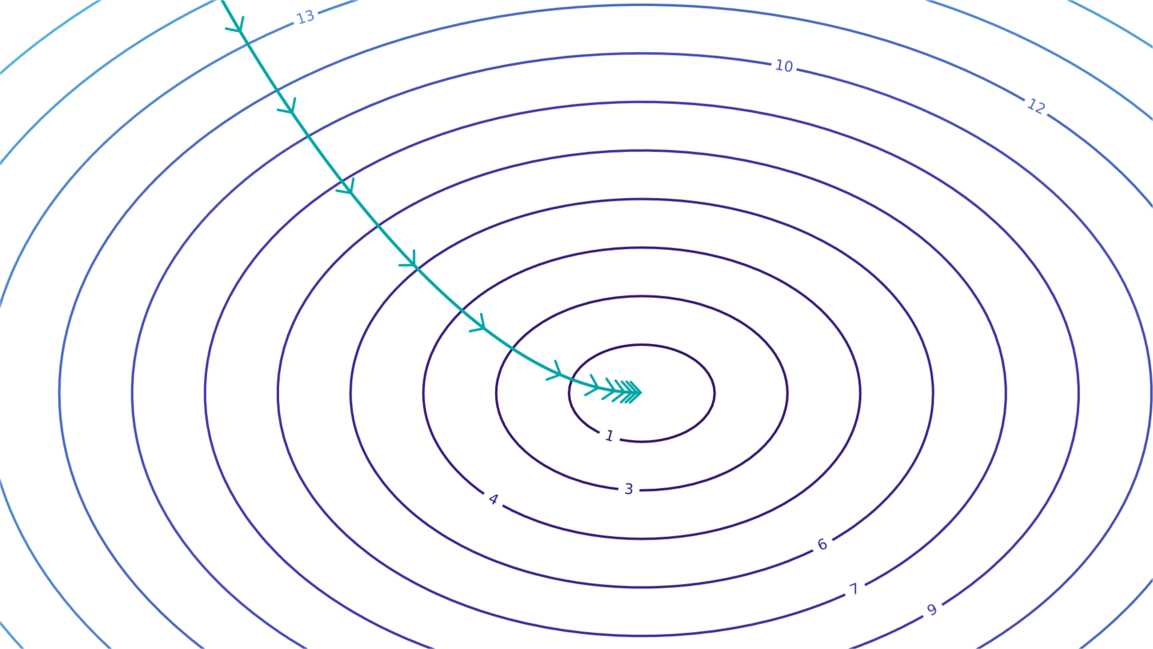

A Epoch AI apresenta o GATE, um modelo de avaliação integrada que explora o impacto econômico da IA. O modelo se concentra em um ciclo de feedback de automação: investimentos impulsionam o poder computacional, levando a sistemas de IA mais capazes que automatizam tarefas, aumentam a produção e impulsionam ainda mais o desenvolvimento da IA. Um playground interativo permite que os usuários alterem os parâmetros e observem o comportamento do modelo em vários cenários. As previsões não são previsões da Epoch AI, mas sim condicionais, baseadas em suposições, principalmente úteis para analisar a dinâmica qualitativa da automação da IA.

Leia mais