FastVLM da Apple: Modelo de Linguagem Visual Ultra-Rápido

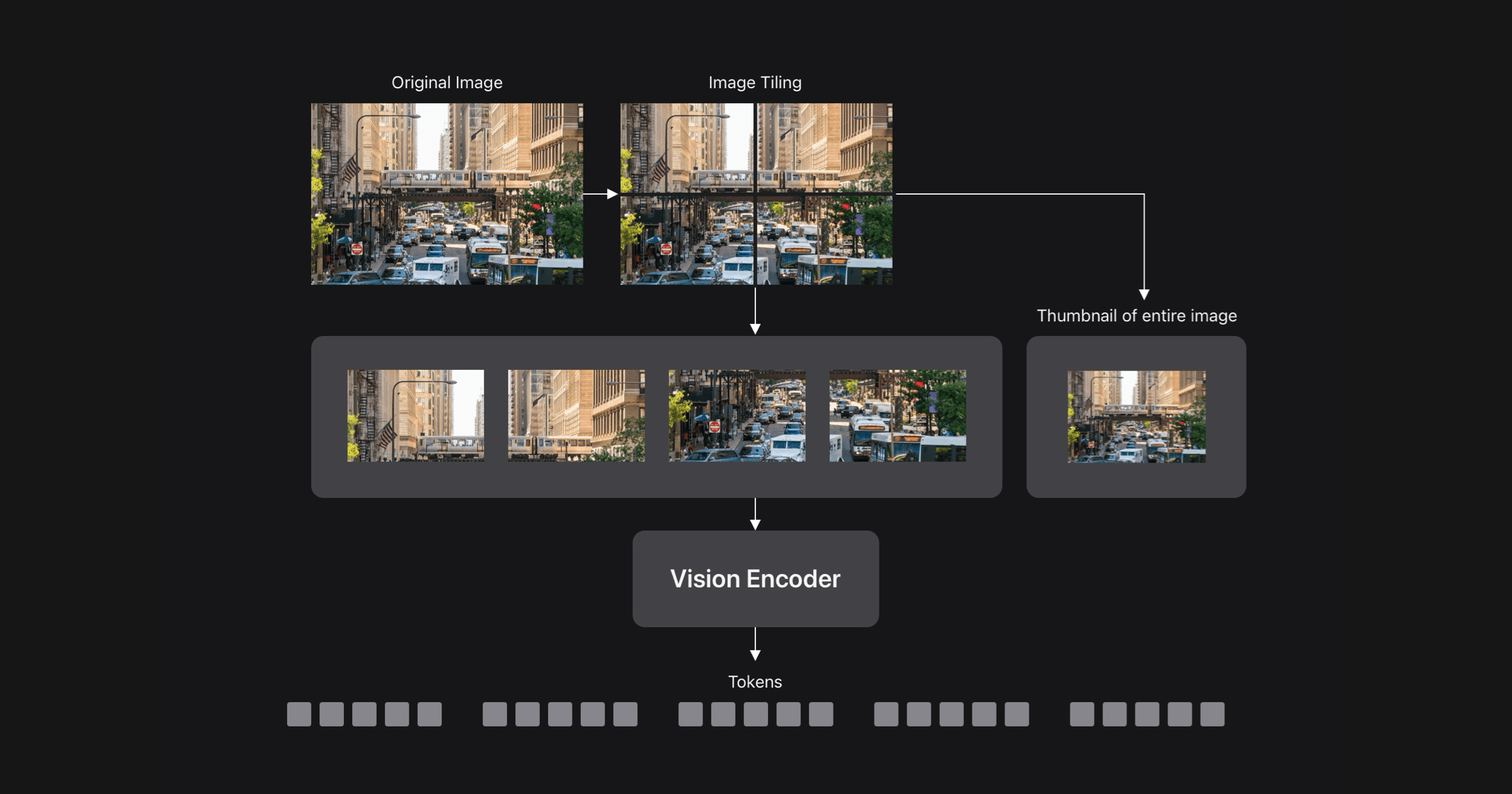

Pesquisadores da Apple ML apresentaram o FastVLM, um novo Modelo de Linguagem Visual (VLM), no CVPR 2025. Abordando o trade-off entre precisão e eficiência inerente aos VLMs, o FastVLM utiliza um codificador de visão de arquitetura híbrida, FastViTHD, projetado para imagens de alta resolução. Isso resulta em um VLM significativamente mais rápido e preciso do que modelos comparáveis, permitindo aplicativos em tempo real em dispositivos e IA que preserva a privacidade. O FastViTHD gera tokens visuais de menor quantidade e maior qualidade, acelerando o pré-preenchimento do LLM. Um aplicativo de demonstração para iOS/macOS mostra as capacidades do FastVLM em dispositivos.

Leia mais