Uma Visão Pragmática de um Cientista de Dados Sênior sobre IA Generativa

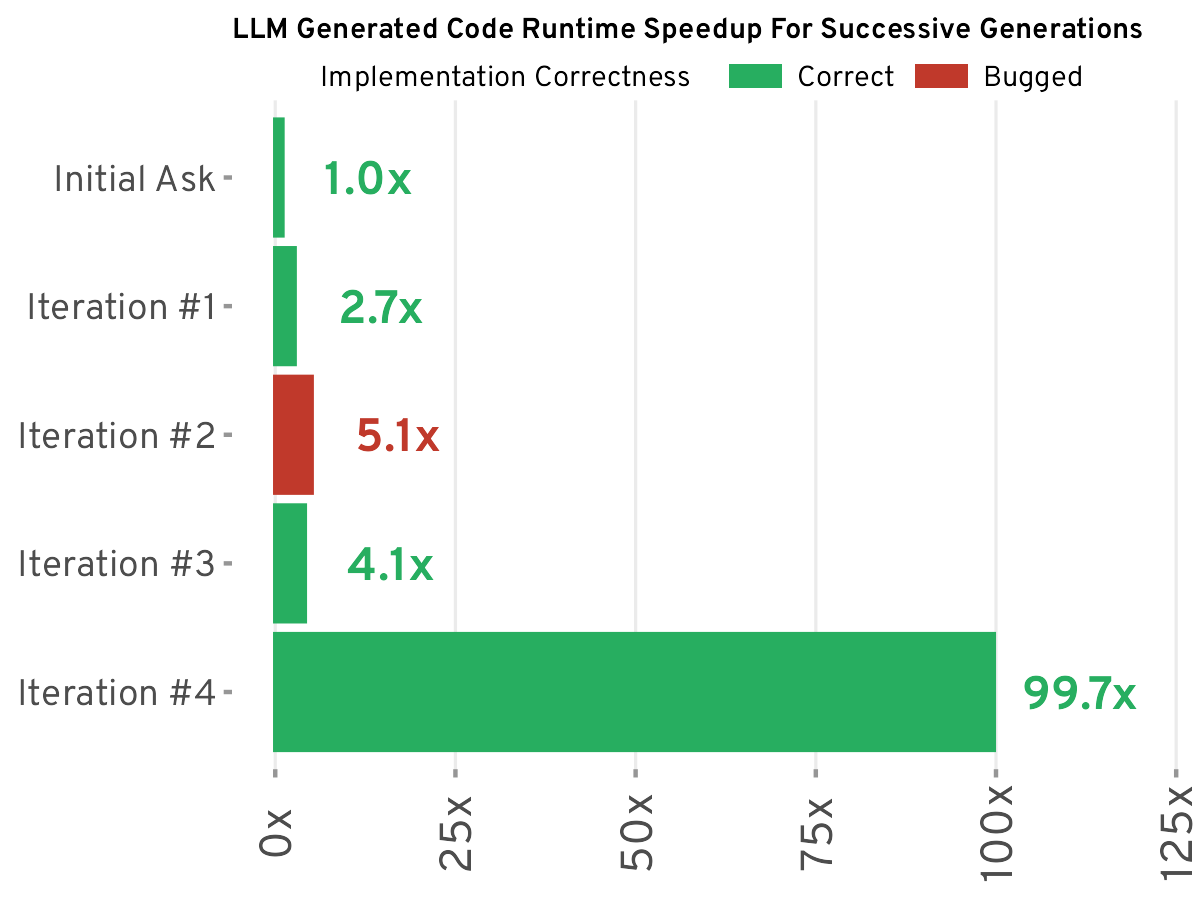

Um cientista de dados sênior do BuzzFeed compartilha sua abordagem pragmática para o uso de modelos de linguagem grandes (LLMs). Ele não vê os LLMs como uma solução mágica, mas sim como uma ferramenta para aumentar a eficiência, destacando a importância da engenharia de prompts. O artigo detalha seu uso bem-sucedido de LLMs para tarefas como categorização de dados, resumo de texto e geração de código, ao mesmo tempo em que reconhece suas limitações, particularmente em cenários complexos de ciência de dados onde a precisão e a eficiência podem ser prejudicadas. Ele argumenta que os LLMs não são uma panacéia, mas, quando usados com sabedoria, podem aumentar significativamente a produtividade. A chave está em selecionar a ferramenta certa para o trabalho.

Leia mais