LLM 0.26 : Les grands modèles de langage se dotent d’outils en terminal

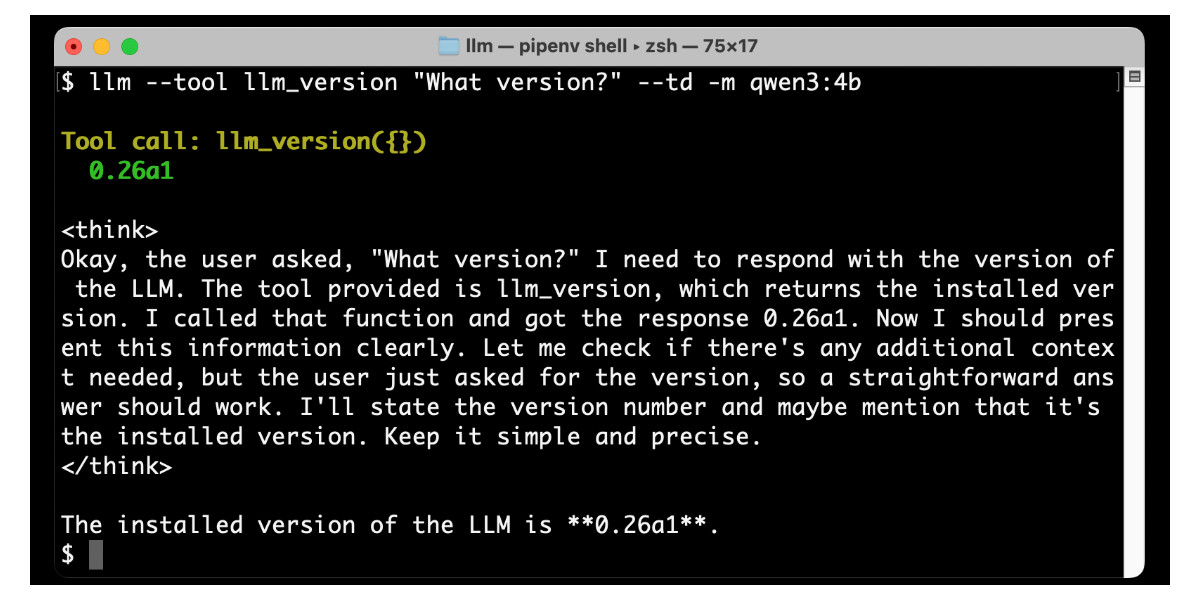

LLM 0.26 est sorti, apportant la fonctionnalité la plus importante depuis le début du projet : la prise en charge des outils. L’interface en ligne de commande LLM et la bibliothèque Python permettent désormais d’accorder aux LLM d’OpenAI, Anthropic, Gemini et aux modèles locaux d’Ollama l’accès à n’importe quel outil représentable sous forme de fonction Python. L’article détaille l’installation et l’utilisation de plugins d’outils, l’exécution d’outils via la ligne de commande ou l’API Python, et présente des exemples avec OpenAI, Anthropic, Gemini et même le petit modèle Qwen-3. Au-delà des outils intégrés, des plugins personnalisés tels que simpleeval (pour les mathématiques), quickjs (pour JavaScript) et sqlite (pour les requêtes de base de données) sont présentés. Cette prise en charge des outils répond aux faiblesses des LLM, comme les calculs mathématiques, en étendant considérablement les capacités et en ouvrant des possibilités pour des applications d’IA puissantes.