Seis Padrões de Projeto para Proteger Agentes LLM Contra Injeção de Prompt

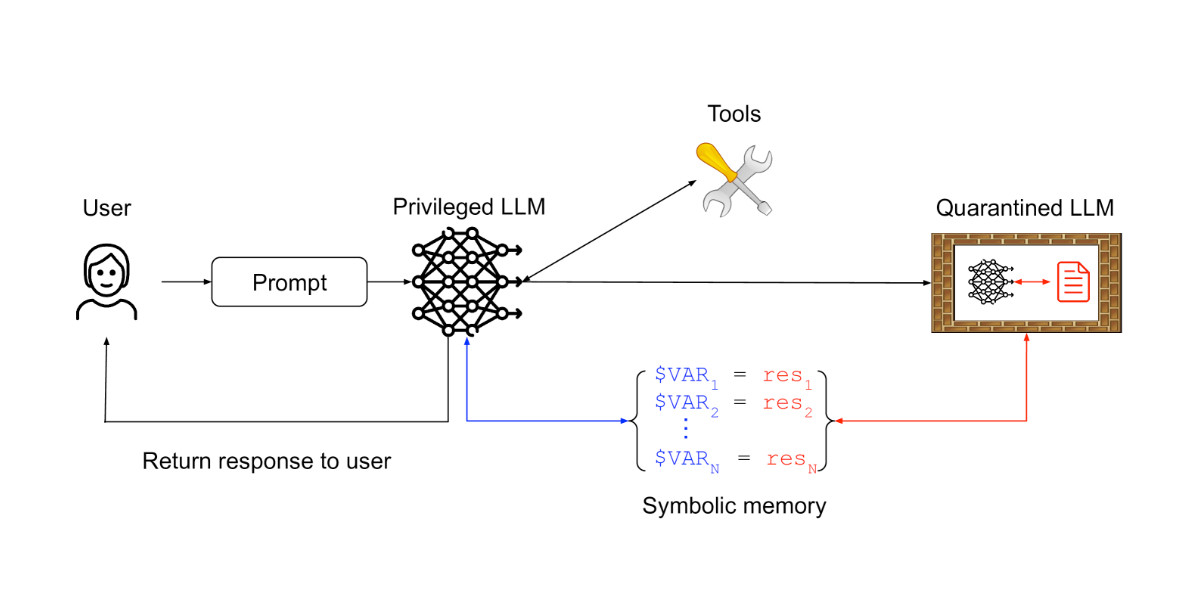

Um novo artigo de pesquisadores da IBM, Invariant Labs e outras instituições apresenta seis padrões de projeto para mitigar o risco de ataques de injeção de prompt contra agentes de modelos de linguagem grandes (LLM). Esses padrões restringem as ações do agente, evitando a execução de tarefas arbitrárias. Exemplos incluem o padrão Seletor de Ação, que impede que o feedback da ferramenta influencie o agente; o padrão Planejar-Então-Executar, que pré-planeja as chamadas de ferramentas; e o padrão LLM Duplo, que usa um LLM privilegiado para coordenar um LLM isolado, evitando a exposição a conteúdo não confiável. O artigo também apresenta dez estudos de caso em vários aplicativos, oferecendo orientação prática para a construção de agentes LLM seguros e confiáveis.