Six modèles de conception pour sécuriser les agents LLM contre l'injection de prompts

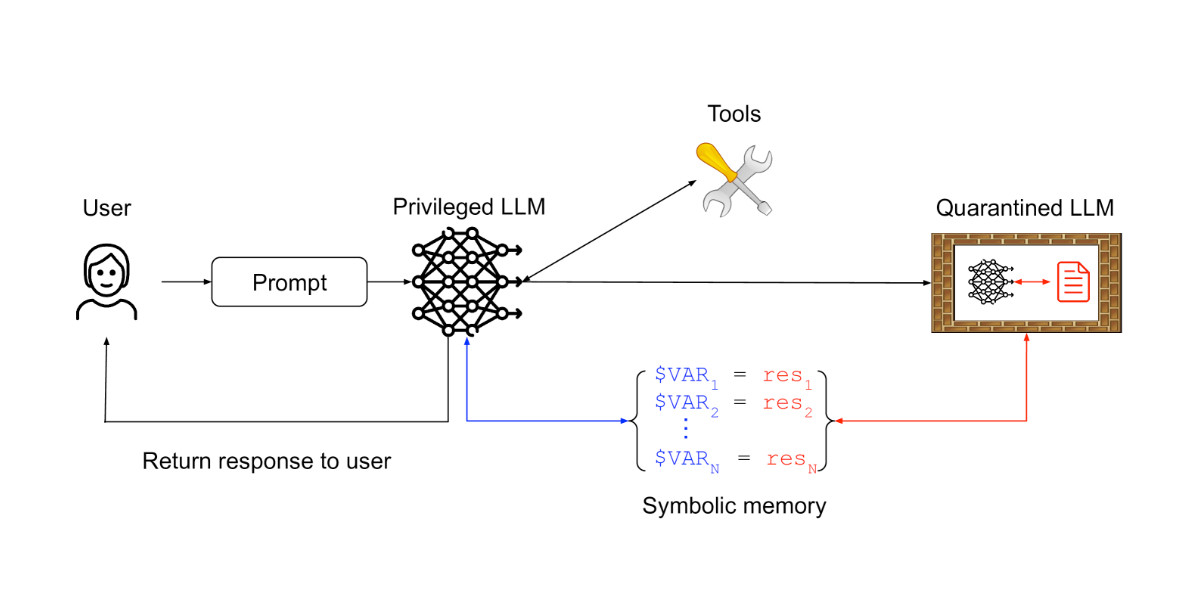

Un nouvel article de chercheurs d'IBM, Invariant Labs et d'autres institutions présente six modèles de conception pour atténuer le risque d'attaques par injection de prompts contre les agents de modèles linguistiques de grande taille (LLM). Ces modèles contraignent les actions de l'agent, empêchant l'exécution de tâches arbitraires. Des exemples incluent le modèle Sélecteur d'action, qui empêche le retour d'information de l'outil d'influencer l'agent ; le modèle Planifier-puis-exécuter, qui pré-planifie les appels d'outils ; et le modèle LLM double, qui utilise un LLM privilégié pour coordonner un LLM isolé, évitant l'exposition à du contenu non fiable. L'article présente également dix études de cas dans diverses applications, offrant des conseils pratiques pour la construction d'agents LLM sûrs et fiables.