Destilação de Conhecimento: Como Pequenos Modelos de IA Desafia os Gigantes

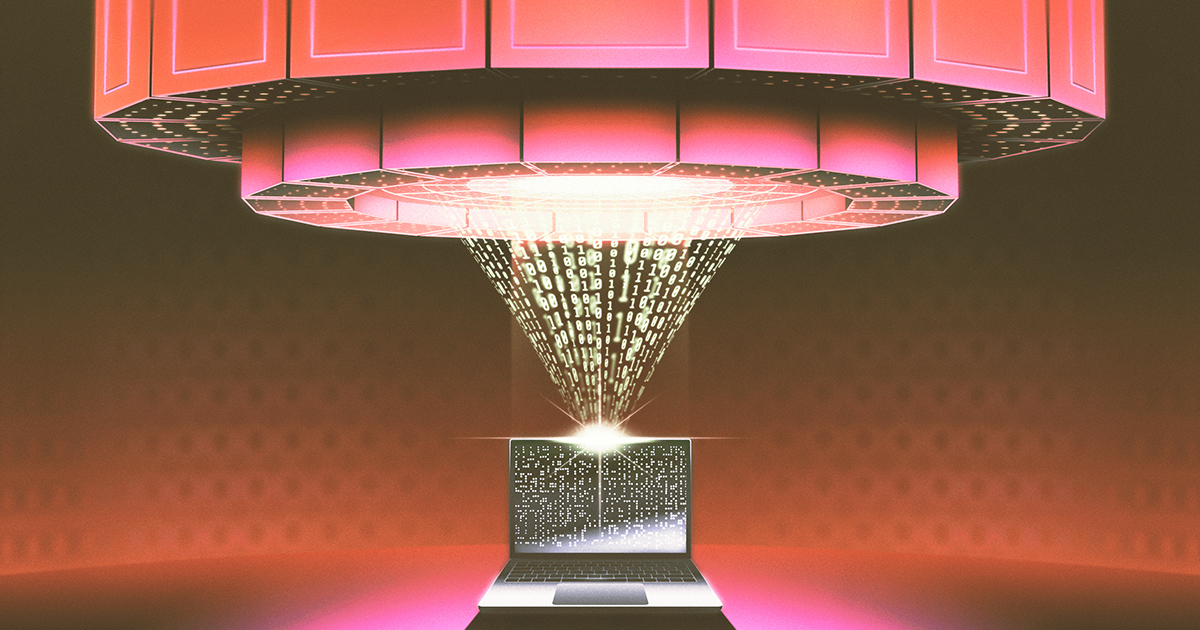

O chatbot R1 da empresa chinesa de IA DeepSeek, lançado no início deste ano, causou sensação ao rivalizar com o desempenho de modelos de IA líderes de grandes empresas, mas a uma fração do custo e da capacidade de computação. Isso levou a acusações de que a DeepSeek usou destilação de conhecimento, uma técnica que pode envolver acesso não autorizado ao modelo o1 da OpenAI. No entanto, a destilação de conhecimento é uma técnica de IA bem estabelecida, datando de um artigo do Google de 2015. Ela envolve a transferência de conhecimento de um modelo 'professor' maior para um modelo 'estudante' menor, reduzindo significativamente os custos e o tamanho com perda mínima de desempenho. Este método tornou-se onipresente, impulsionando melhorias em modelos como o BERT, e continua a mostrar um potencial imenso em vários aplicativos de IA. A controvérsia destaca o poder e a natureza estabelecida dessa técnica, não sua novidade.