Ajuste fino eficiente: Una inmersión profunda en LoRA (Parte 1)

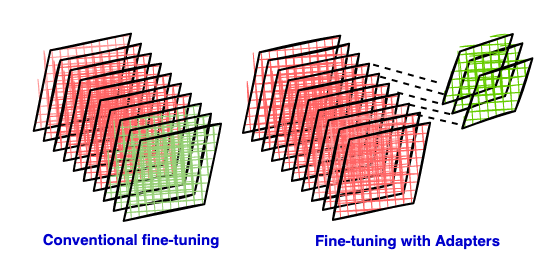

El ajuste fino de los grandes modelos de lenguaje generalmente requiere recursos computacionales sustanciales. Este artículo presenta LoRA, una técnica de ajuste fino eficiente en cuanto a parámetros. LoRA reduce significativamente la cantidad de parámetros que necesitan ser entrenados insertando matrices de bajo rango como adaptadores en un modelo preentrenado, reduciendo así los costos computacionales y de almacenamiento. Esta primera parte explica los principios detrás de LoRA, incluidas las deficiencias del ajuste fino tradicional, las ventajas de los métodos eficientes en cuanto a parámetros y la base matemática de la aproximación de bajo rango. Partes posteriores profundizarán en la implementación y aplicación específicas de LoRA.