Effizientes Feintuning: Ein tiefer Einblick in LoRA (Teil 1)

2024-12-25

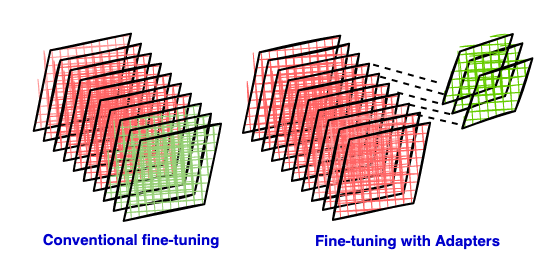

Das Feintuning großer Sprachmodelle erfordert in der Regel erhebliche Rechenressourcen. Dieser Artikel stellt LoRA vor, eine parametereffiziente Feintuning-Technik. LoRA reduziert die Anzahl der zu trainierenden Parameter erheblich, indem es Matrizen mit niedrigem Rang als Adapter in ein vortrainiertes Modell einfügt, wodurch die Rechen- und Speicherkosten gesenkt werden. Dieser erste Teil erklärt die Prinzipien hinter LoRA, einschließlich der Mängel des traditionellen Feintunings, der Vorteile parametereffizienter Methoden und der mathematischen Grundlage der Niedrigrang-Approximation. Nachfolgende Teile werden tiefer in die spezifische Implementierung und Anwendung von LoRA eintauchen.