효율적인 파인튜닝: LoRA 심층 분석 (1부)

2024-12-25

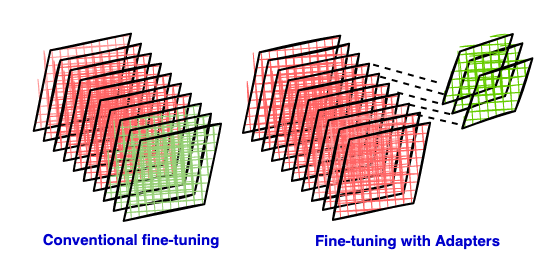

대규모 언어 모델의 파인튜닝은 일반적으로 상당한 컴퓨팅 리소스를 필요로 합니다. 이 글에서는 매개변수 효율적인 파인튜닝 기법인 LoRA를 소개합니다. LoRA는 사전 훈련된 모델에 저랭크 행렬을 어댑터로 삽입하여 훈련에 필요한 매개변수 수를 크게 줄이고, 컴퓨팅 및 스토리지 비용을 절감합니다. 이 1부에서는 기존 파인튜닝의 단점, 매개변수 효율적인 방법의 장점, 저랭크 근사의 수학적 기초를 포함하여 LoRA의 기본 원리를 설명합니다. 후속 부분에서는 LoRA의 구체적인 구현 및 응용에 대해 자세히 설명합니다.