Modelo LLM menor que 100MB agora instalável via pip: Apresentando llm-smollm2

2025-02-07

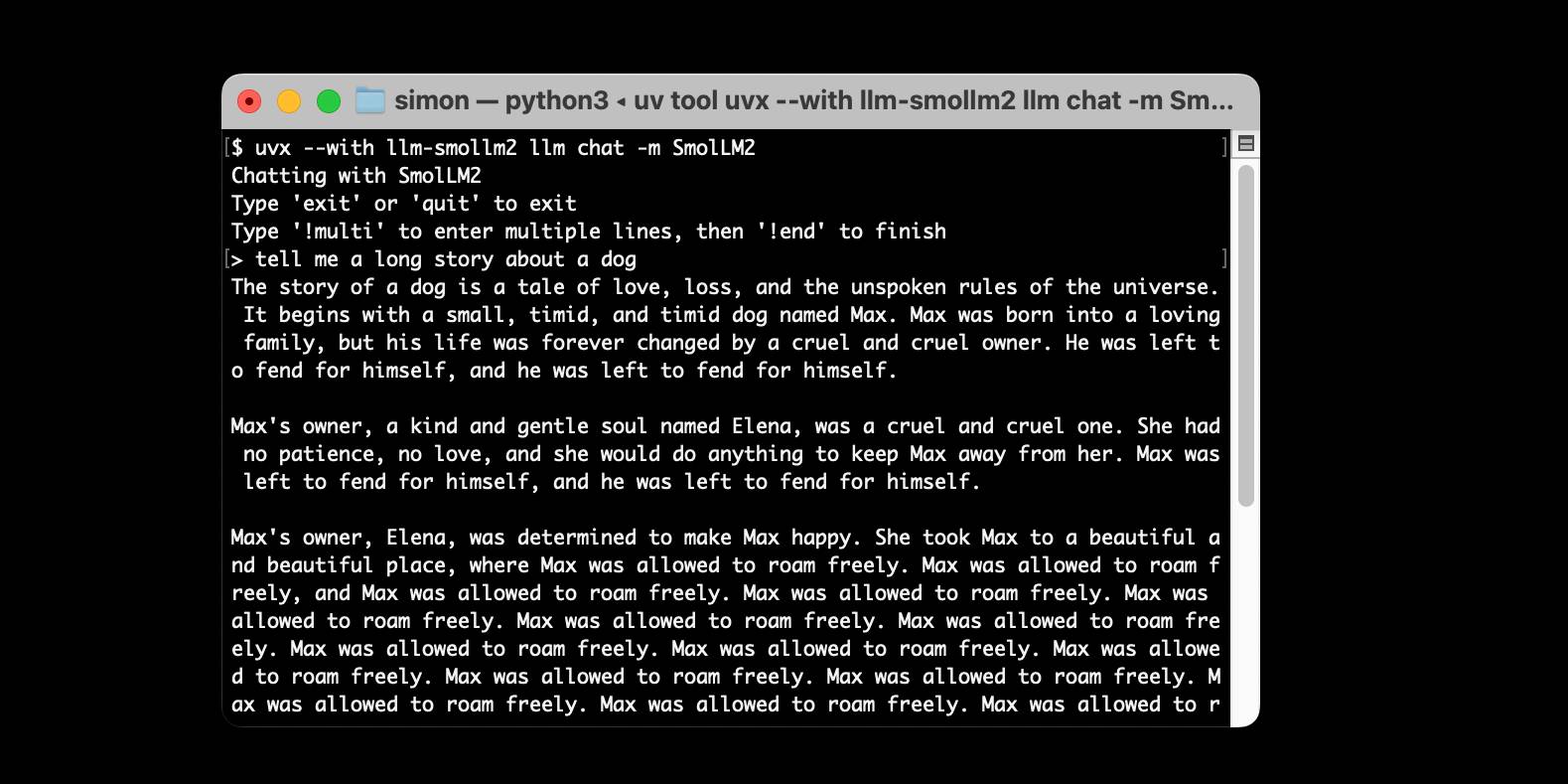

Um novo plugin, llm-smollm2, inclui um modelo LLM SmolLM2-135M-Instruct quantizado com menos de 100MB, tornando-o instalável via pip. O autor detalha o processo de criação, desde encontrar um modelo adequado com menos de 100MB (limitado pelas restrições de tamanho do PyPI) até suprimir logs detalhados do llama-cpp-python e empacotar para o PyPI. Embora as capacidades do modelo sejam limitadas, ele é apresentado como uma ferramenta de aprendizado valiosa para entender a tecnologia LLM.

Desenvolvimento

Quantização de Modelo