如何解决大型语言模型的幻觉问题

2024-06-14

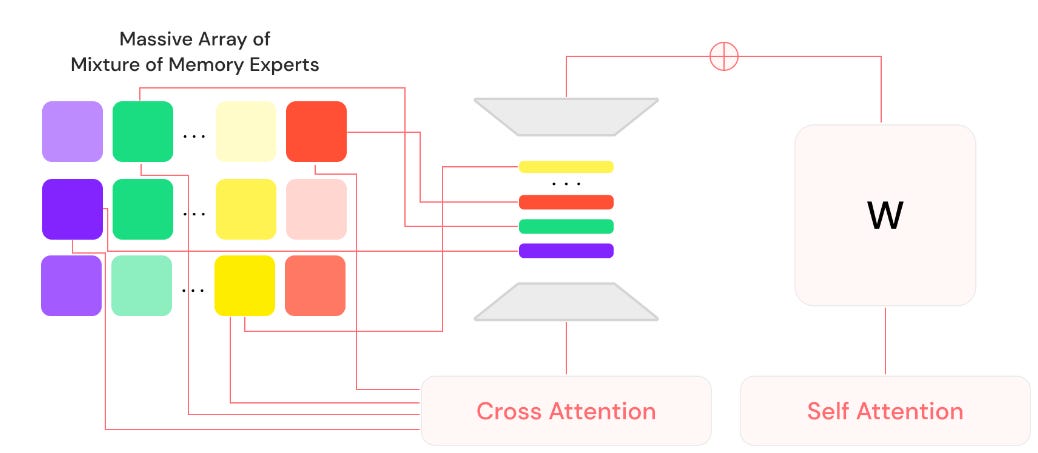

本文介绍了大型语言模型(LLM)中存在的“幻觉”问题,即模型生成与事实不符或逻辑错误信息的现象。文章探讨了幻觉问题产生的原因,包括训练数据中的错误信息、模型过度依赖概率函数生成结果等。作者还介绍了目前解决幻觉问题的一些方法,如领域特定模型、联合提示、微调、检索增强生成以及专家混合模型等,并分析了它们的优缺点。文章重点介绍了初创公司Lamini提出的一种名为“记忆调优”的新方法,该方法通过创建“记忆专家混合模型”(MoME)来解决幻觉问题。文章最后讨论了MoME方法的潜在影响,认为它可能会像Transformer架构一样,推动机器学习计算模式的变革。

未分类

幻觉问题