AppleのFastVLM:超高速ビジョン言語モデル

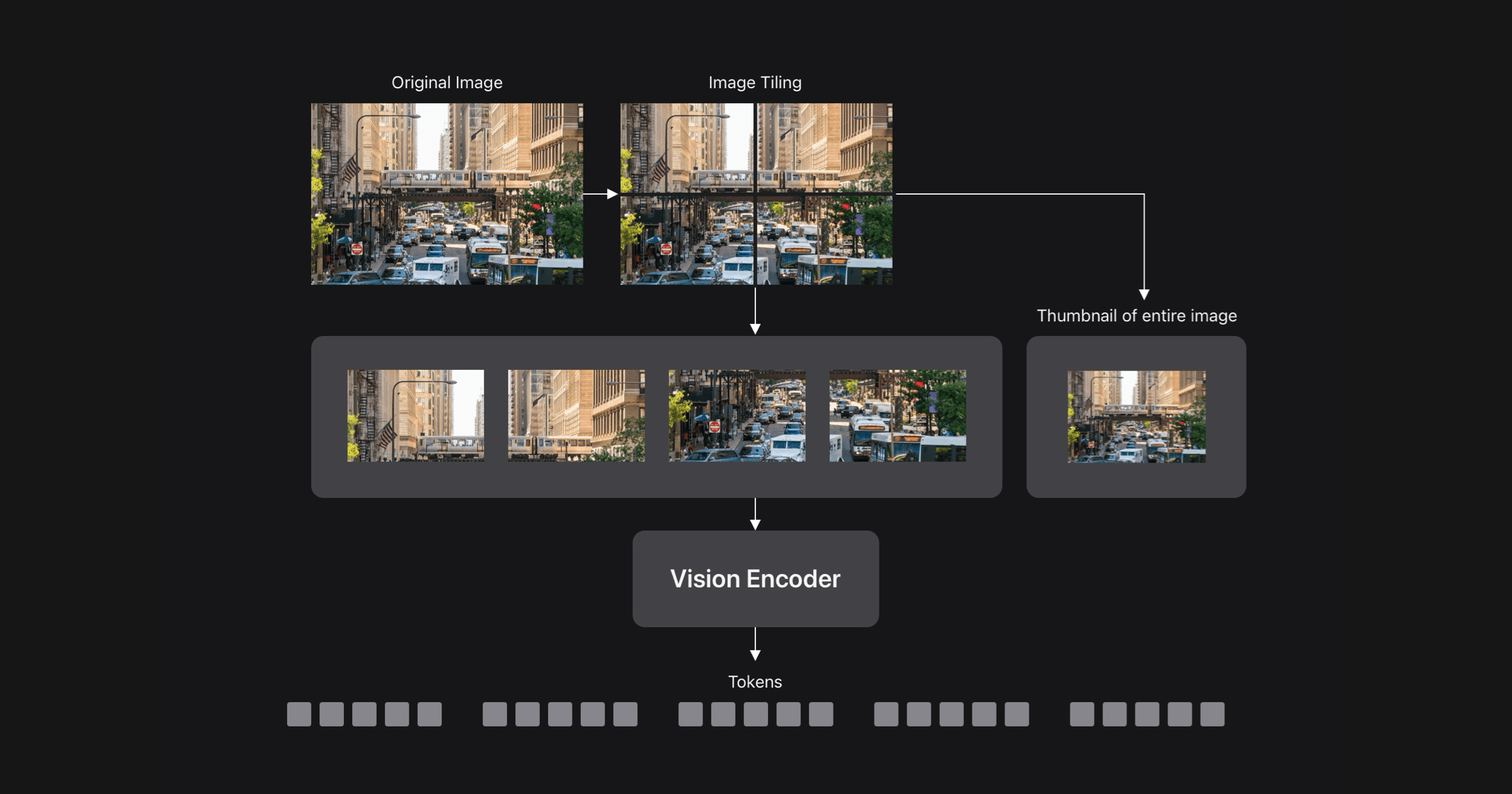

AppleのML研究者たちは、CVPR 2025で、新しいビジョン言語モデル(VLM)であるFastVLMを発表しました。VLMに固有の精度と効率のトレードオフに対処するために、FastVLMは高解像度画像用に設計されたハイブリッドアーキテクチャのビジョンエンコーダであるFastViTHDを使用しています。これにより、同等のモデルよりもはるかに高速で正確なVLMが実現し、デバイス上のリアルタイムアプリケーションやプライバシーを保護するAIを可能にします。FastViTHDは、より少ない数の高品質な視覚トークンを生成し、LLMのプリフィリングを高速化します。iOS/macOSデモアプリは、デバイス上のFastVLMの機能を示しています。

続きを読む