Seis Maneiras de Domar a Fera: Mitigação de Falhas de Contexto em LLMs

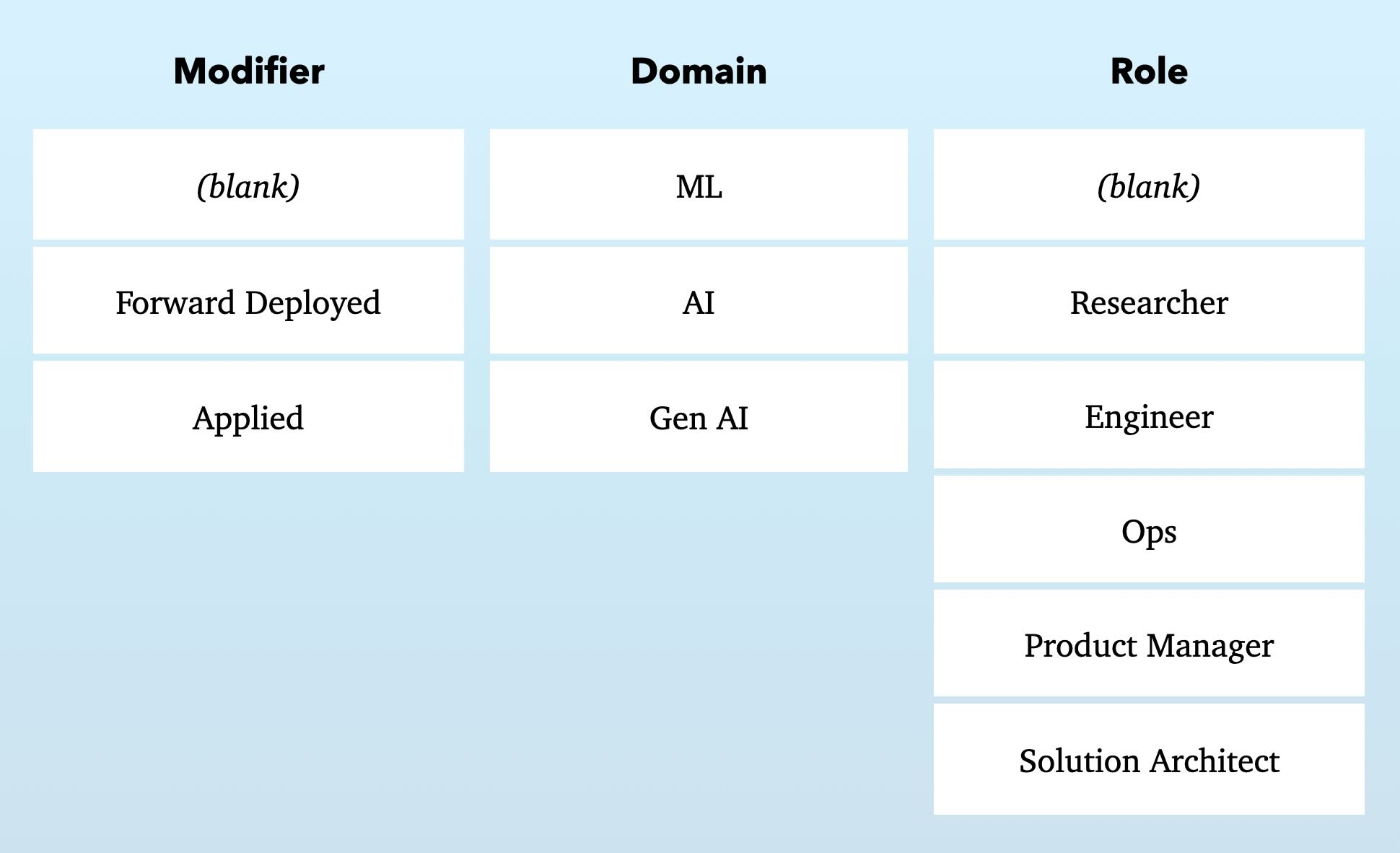

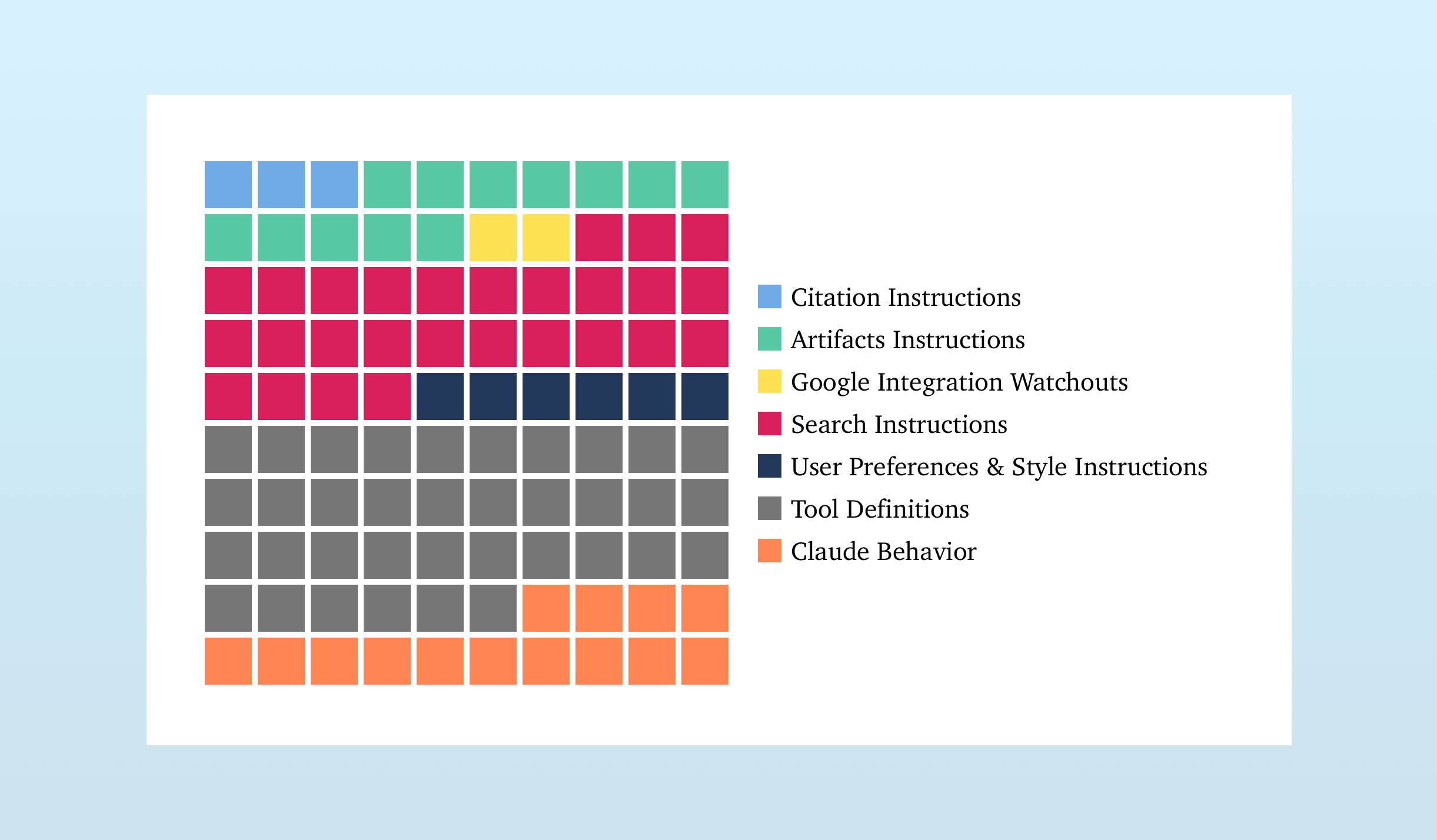

Modelos de linguagem grandes (LLMs) possuem janelas de contexto cada vez maiores, mas o contexto excessivo pode prejudicar o desempenho. Este artigo detalha seis estratégias de mitigação: Geração Aumentada por Recuperação (RAG) para adição seletiva de informações; Configuração de Ferramentas para escolher ferramentas relevantes; Quarentena de Contexto para isolar contextos em threads separados; Poda de Contexto para remover informações irrelevantes; Resumo de Contexto para condensar o contexto; e Descarga de Contexto para armazenar informações fora do contexto do LLM. Estudos mostram que esses métodos melhoram significativamente a precisão e a eficiência do modelo, particularmente ao lidar com inúmeras ferramentas ou tarefas complexas.

Leia mais