极简Transformer模型揭秘:用1万参数理解语言模型的内部机制

2025-09-04

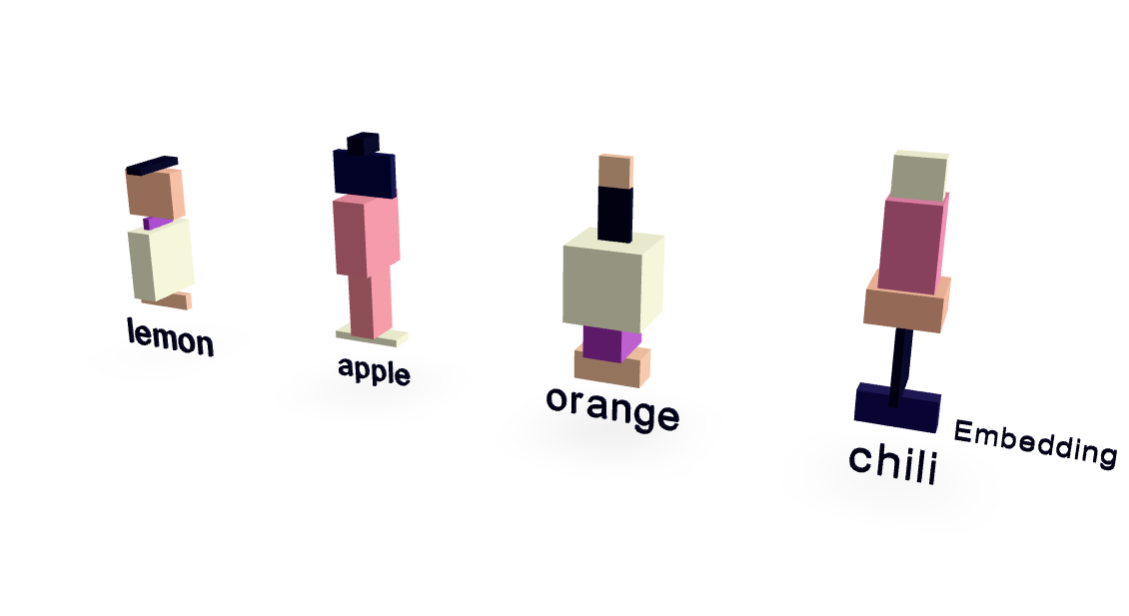

这篇论文通过极简的训练数据、分词方法和模型架构,构建了一个仅含1万参数的Transformer模型,成功地解释了大型语言模型(LLM)的内部工作机制。该模型使用一个极小的水果和味道数据集进行训练,并通过可视化技术展示了模型内部的嵌入向量和注意力机制是如何工作的。令人惊奇的是,这个简化模型不仅在训练数据上表现出色,还在验证集上成功预测了“辣椒”与“辣”之间的关系,证明了其泛化能力,而非简单的记忆。

AI