LLM推理后端性能基准测试:vLLM、LMDeploy、MLC-LLM、TensorRT-LLM 和 TGI

2024-07-06

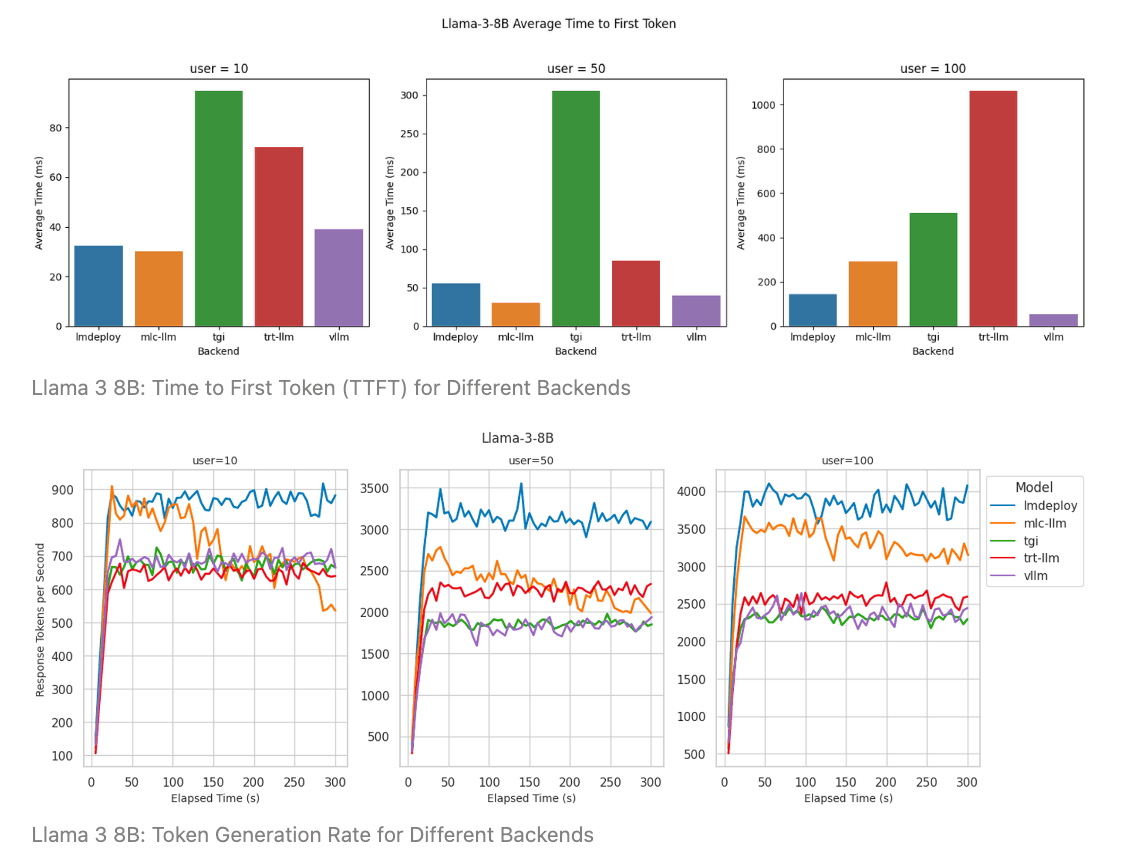

本文对不同的LLM推理后端(vLLM、LMDeploy、MLC-LLM、TensorRT-LLM 和 Hugging Face TGI)进行了全面的基准测试,评估指标包括首个token时间(TTFT)和token生成速率。测试结果表明,对于Llama 3 8B模型,LMDeploy在所有用户负载下均表现出色,而vLLM则在低延迟场景中表现出色;对于Llama 3 70B Q4模型,LMDeploy在低延迟和高吞吐量方面均表现最佳,而TensorRT-LLM在吞吐量方面与LMDeploy相当。文章还分析了不同后端的优缺点,并为选择合适的推理后端提供了建议。

72

未分类

推理后端