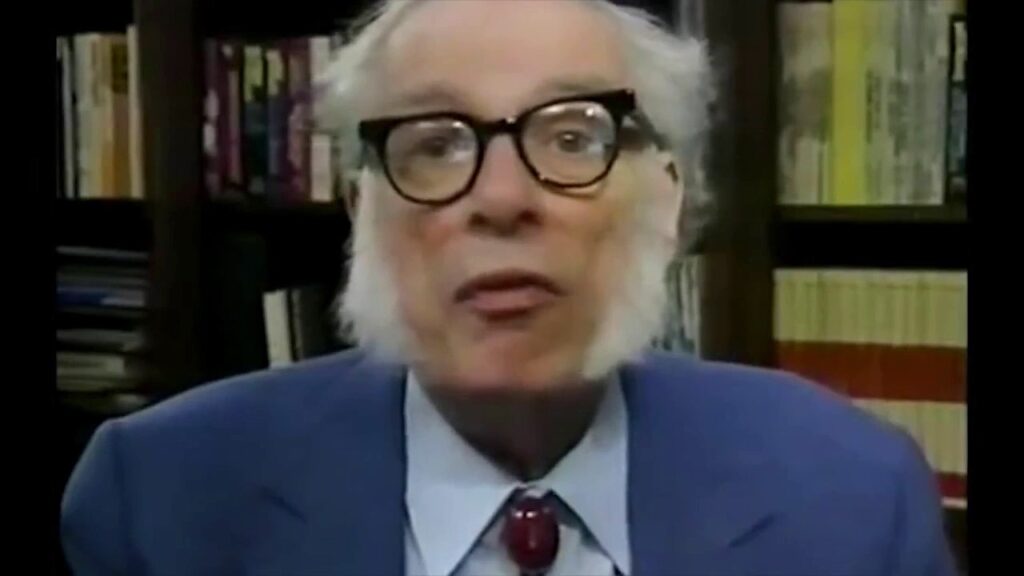

Les prédictions d'Asimov sur l'IA en 1982 : Collaboration, pas compétition

Cet article revient sur une interview de 1982 avec l'écrivain de science-fiction Isaac Asimov, où il définissait l'intelligence artificielle comme tout dispositif effectuant des tâches auparavant associées uniquement à l'intelligence humaine. Asimov voyait l'IA et l'intelligence humaine comme complémentaires, non concurrentes, arguant que leur collaboration mènerait à un progrès plus rapide. Il prévoyait que l'IA libérerait les humains des tâches ne nécessitant pas de pensée créative, mais mettait aussi en garde contre les difficultés et les défis potentiels du progrès technologique, en prenant l'exemple de l'arrivée de l'automobile. Il soulignait la nécessité de se préparer à l'ère de l'IA et d'éviter de répéter les erreurs du passé.