Un doctorat en IA réfléchit sur les LLMs : outils utiles ou béquilles ?

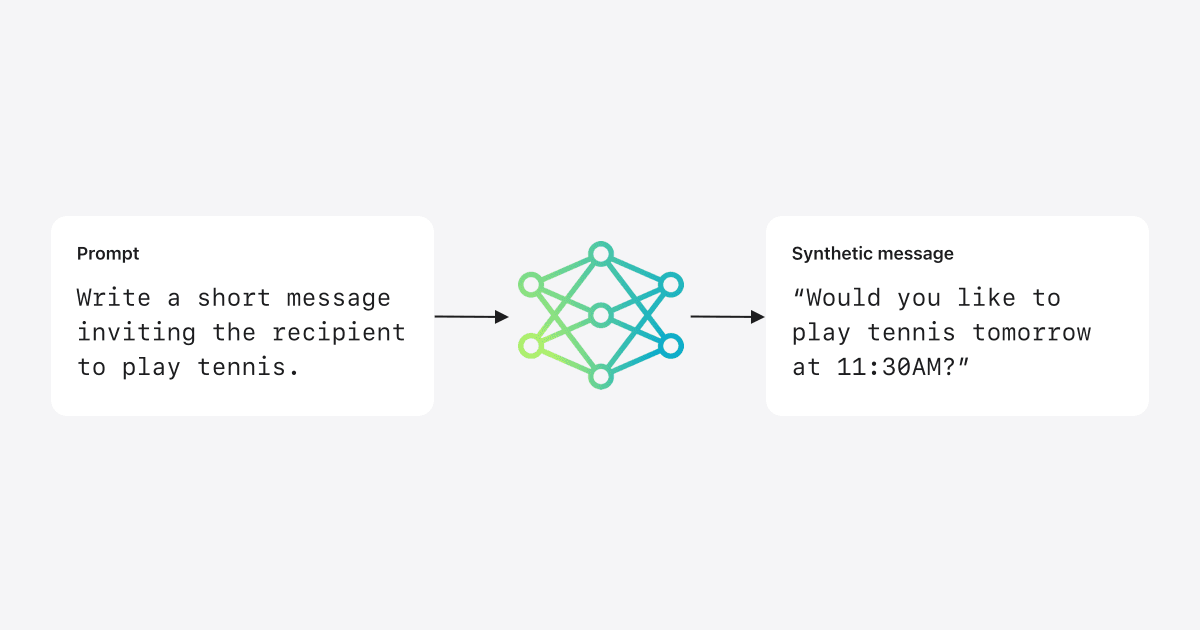

Un doctorant en IA de 2024 et auteur d'un livre sur les LLMs partage son point de vue nuancé sur les grands modèles de langage. Il ne les rejette pas complètement, mais aborde leurs capacités et leurs limites avec prudence. Il détaille comment il utilise les LLMs pour l'assistance à la rédaction, la récupération d'informations et la résolution de problèmes techniques, tout en reconnaissant ouvertement leurs défauts : erreurs, manque de réflexion approfondie et dépendance excessive aux points de vue établis. Il soutient que les LLMs sont des outils, et non des remplaçants de la pensée, exigeant une pensée critique et une vérification minutieuse pour une utilisation efficace.