Nouveau moteur multimodale d'Ollama : inférence locale pour les modèles de vision

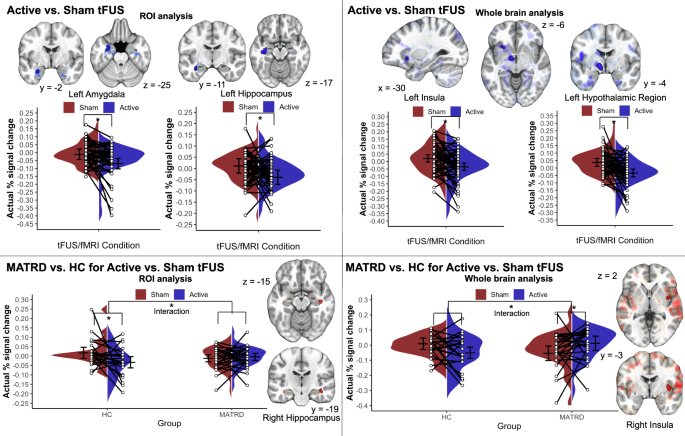

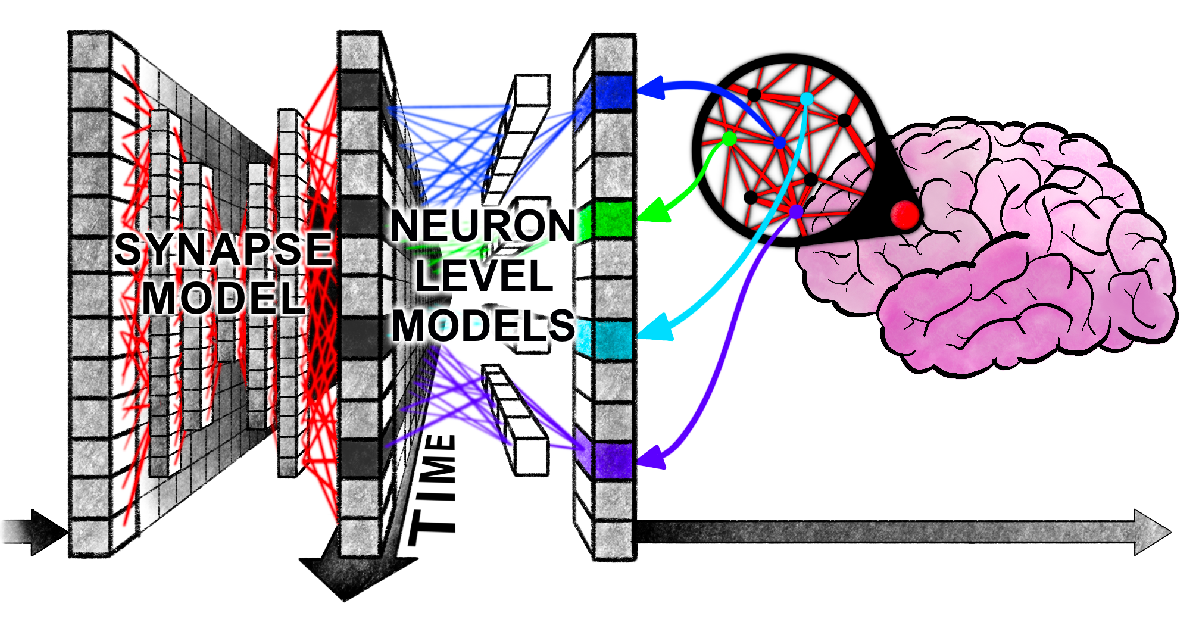

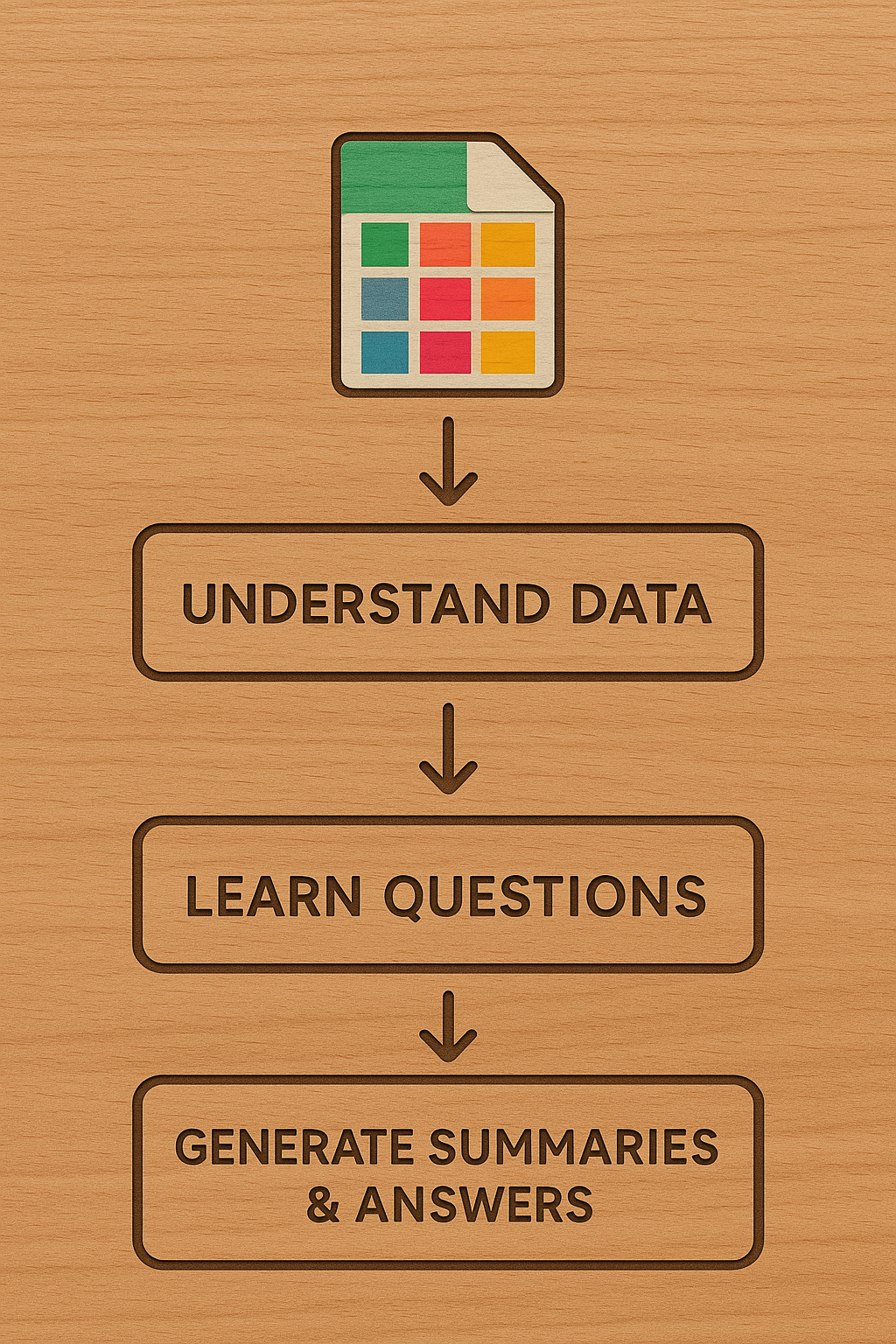

Ollama a lancé un nouveau moteur prenant en charge l'inférence locale pour les modèles multimodaux, en commençant par les modèles de vision comme Llama 4 Scout et Gemma 3. En abordant les limitations de la bibliothèque ggml pour les modèles multimodaux, le moteur améliore la modularité du modèle, la précision et la gestion de la mémoire pour une inférence fiable et efficace avec des images de grande taille et des architectures complexes (y compris les modèles Mixture-of-Experts). Cette focalisation sur la précision et la fiabilité jette les bases pour la prise en charge future de la parole, de la génération d'images et de contextes plus longs.