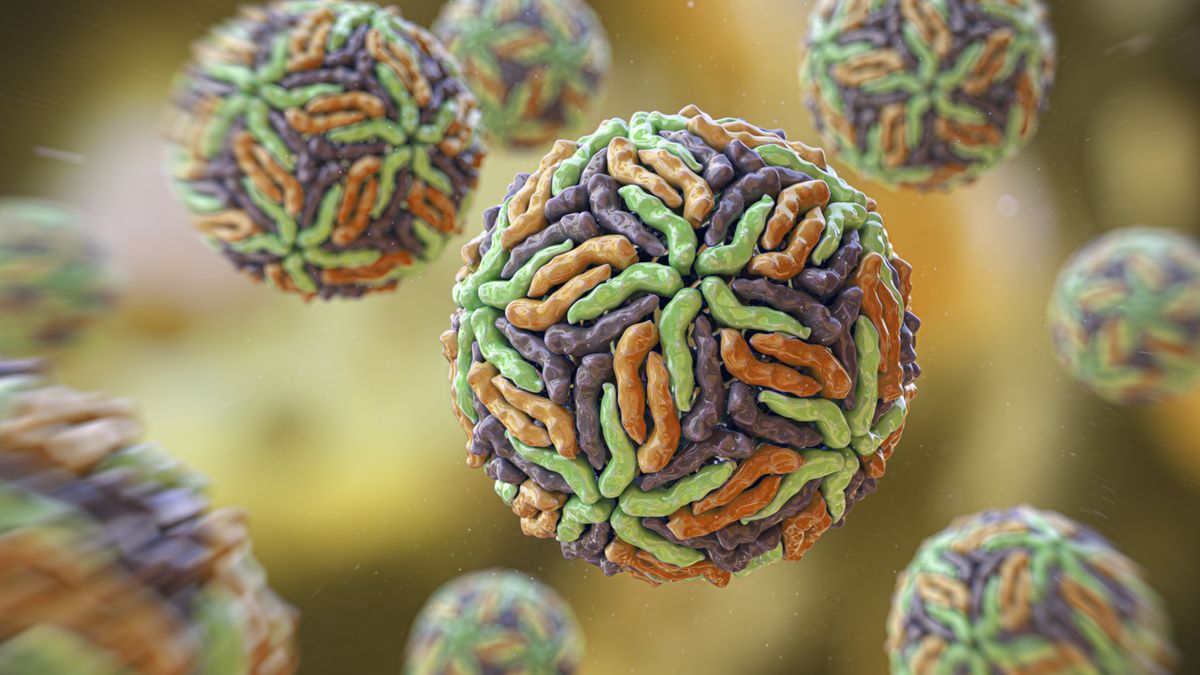

Sesame AI Lança Modelo de Fala Conversacional de 1 Bilhão de Parâmetros

Os Laboratórios Sesame AI lançaram o CSM (Conversational Speech Model), um modelo de geração de fala de 1 bilhão de parâmetros baseado na arquitetura Llama. O CSM gera códigos de áudio RVQ a partir de entradas de texto e áudio, e seu checkpoint está disponível no Hugging Face. Também são fornecidos uma demonstração interativa de voz e um espaço Hugging Face para testar a geração de áudio. Embora seja capaz de produzir vozes variadas, o CSM não foi ajustado para vozes específicas e tem suporte multilíngue limitado. A Sesame AI enfatiza seu uso apenas para fins de pesquisa e educacionais, proibindo a personificação, desinformação e atividades ilegais.