O Dilema Ético dos LLMs: Por que Parei de Usá-los

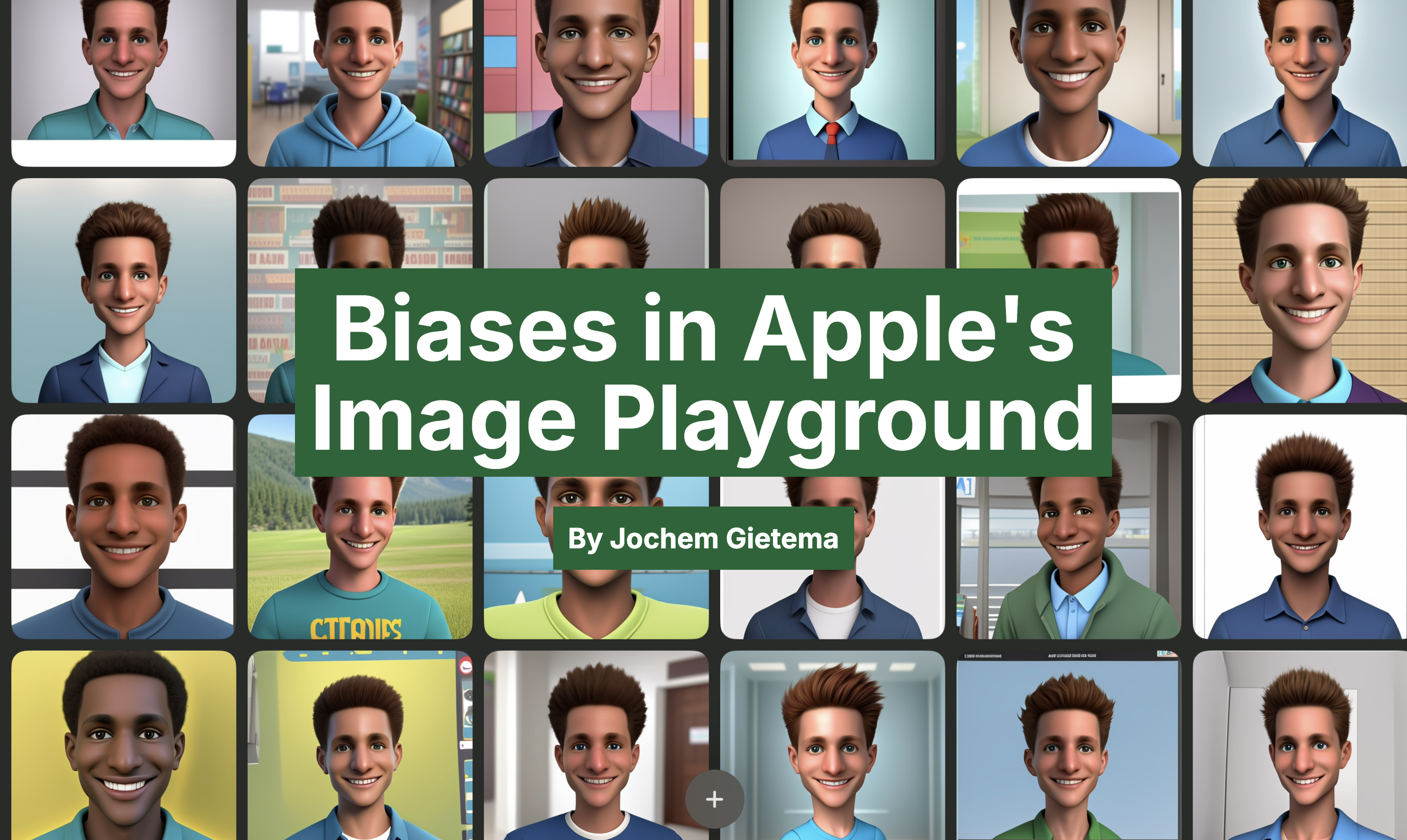

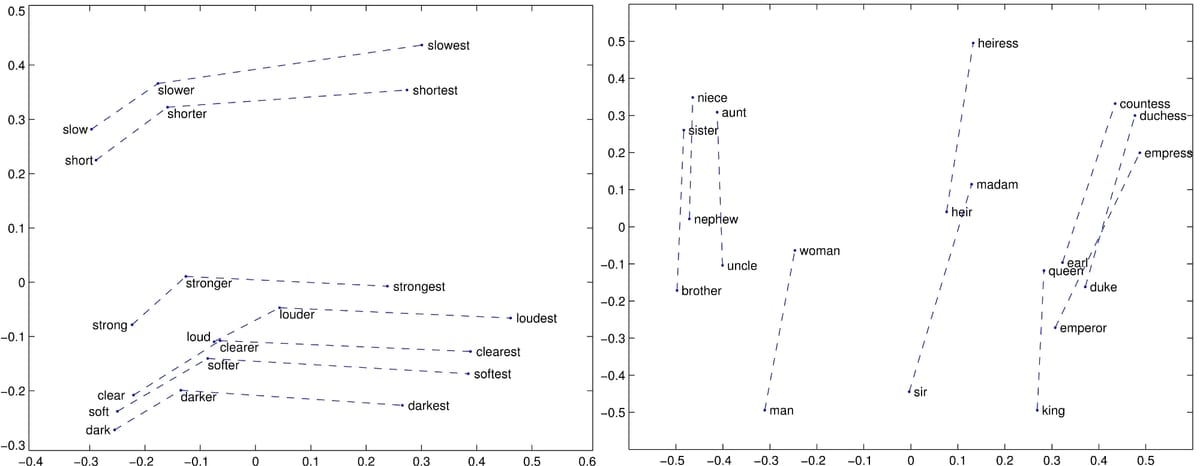

Este artigo mergulha nas preocupações éticas em torno dos Grandes Modelos de Linguagem (LLMs) e explica a decisão do autor de parar de usá-los. O autor explora cinco questões principais: consumo de energia, origem dos dados de treinamento, deslocamento de empregos, informações imprecisas e vieses, e concentração de poder. O alto consumo de energia, preocupações com a privacidade relacionadas aos dados de treinamento, o potencial de deslocamento de empregos, o risco de desinformação devido a vieses e imprecisões e a concentração de poder nas mãos de algumas grandes empresas de tecnologia são destacados como problemas éticos significativos. O autor argumenta que usar LLMs sem abordar ativamente essas preocupações éticas é antiético.