DeepSeek e Controles de Exportação: Uma Corrida Armamentista de IA

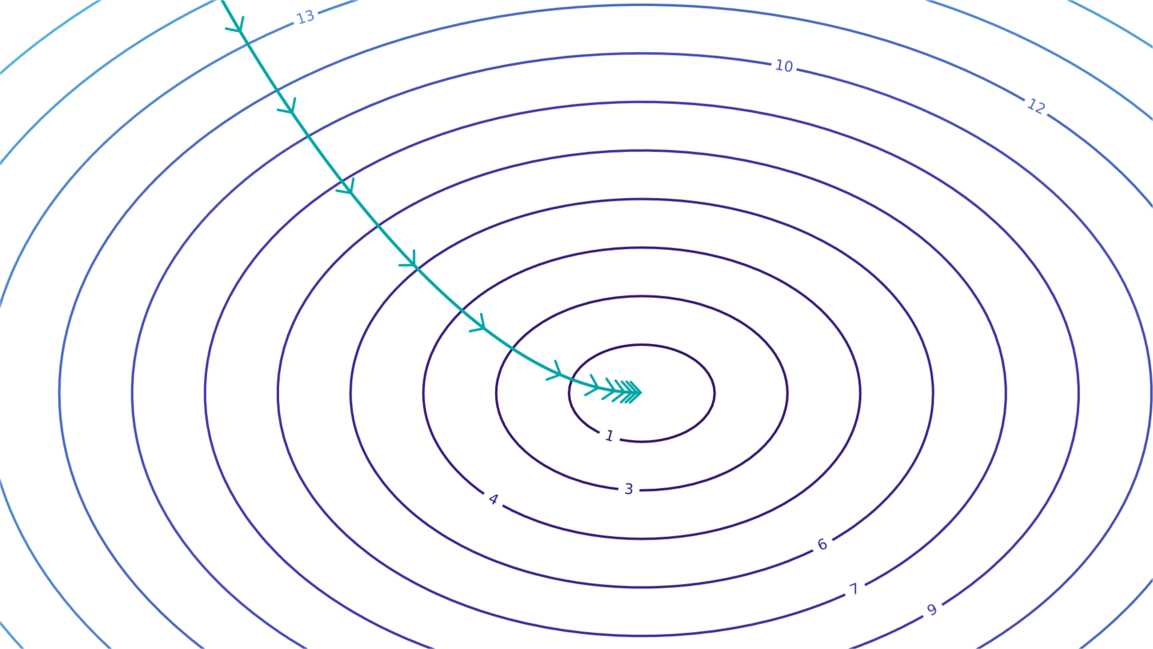

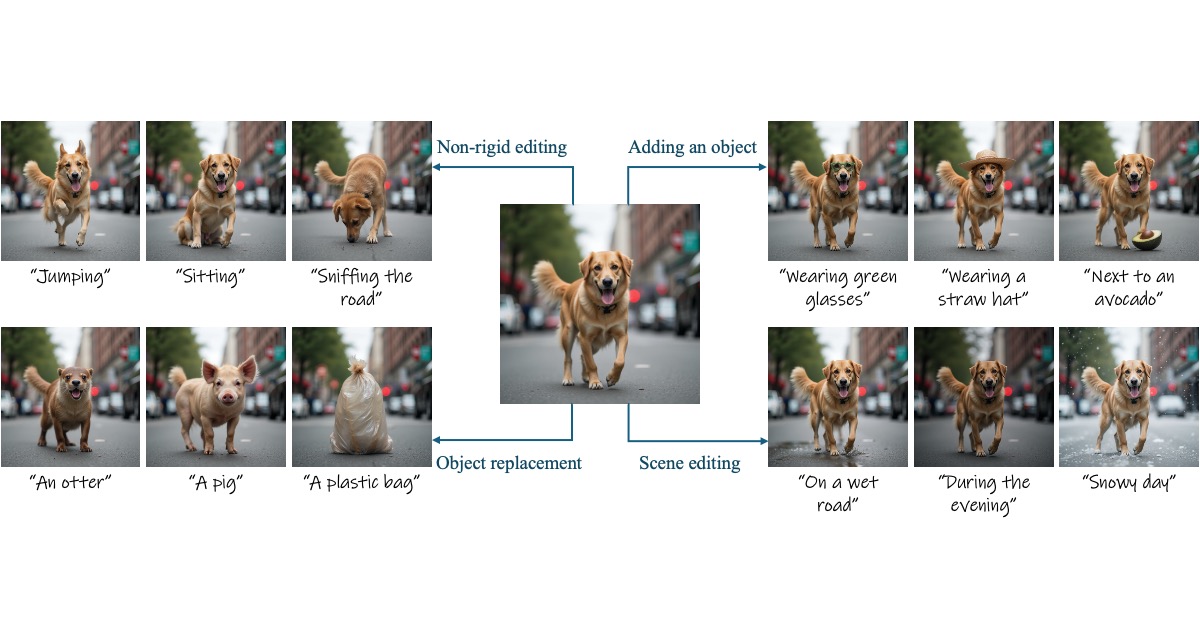

O artigo de Dario Amodei examina a ascensão da empresa chinesa de IA DeepSeek e suas implicações para as políticas de controle de exportação de chips dos EUA. A DeepSeek, por meio de inovações de engenharia eficientes, alcançou quase paridade com os principais modelos de IA dos EUA a um custo menor. Amodei argumenta que o sucesso da DeepSeek não nega os controles de exportação, mas destaca sua importância. Ele analisa três dinâmicas do desenvolvimento de IA: leis de escala, mudança de curva e mudanças de paradigma, concluindo que o progresso da DeepSeek está alinhado com as tendências esperadas de redução de custos. Por fim, Amodei enfatiza que os controles de exportação são cruciais para impedir que a China adquira grandes quantidades de chips, evitando assim um cenário bipolar de IA e salvaguardando a liderança global dos EUA.