OpenAI发布开源大型语言模型gpt-oss:本地运行的强大推理引擎

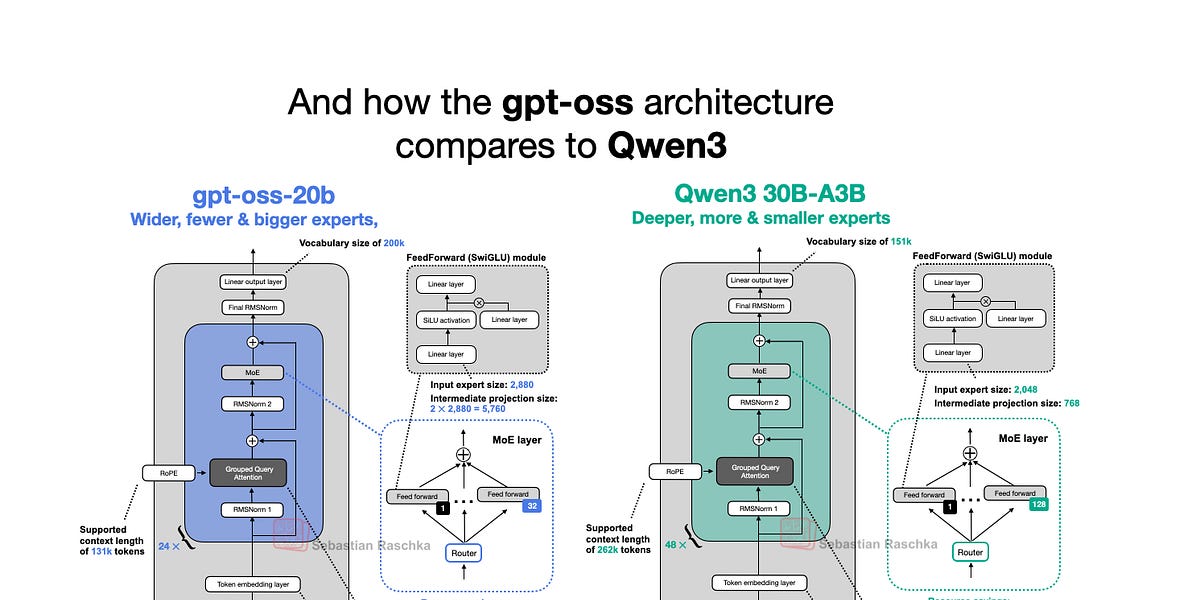

OpenAI本周发布了其首个自2019年GPT-2以来重量级开源大型语言模型gpt-oss-120b和gpt-oss-20b。令人惊喜的是,通过巧妙的优化,它们可以在本地运行。文章深入探讨了gpt-oss模型架构,包括其与GPT-2和Qwen3等模型的比较,重点分析了其独特的架构设计选择,如混合专家(MoE)、分组查询注意力(GQA)和滑动窗口注意力等。尽管在某些基准测试中,gpt-oss的表现与闭源模型持平,但其本地运行能力和开源属性使其成为研究和应用的宝贵资源。

阅读更多