GenAIの推論欠陥が偽情報の蔓延を助長

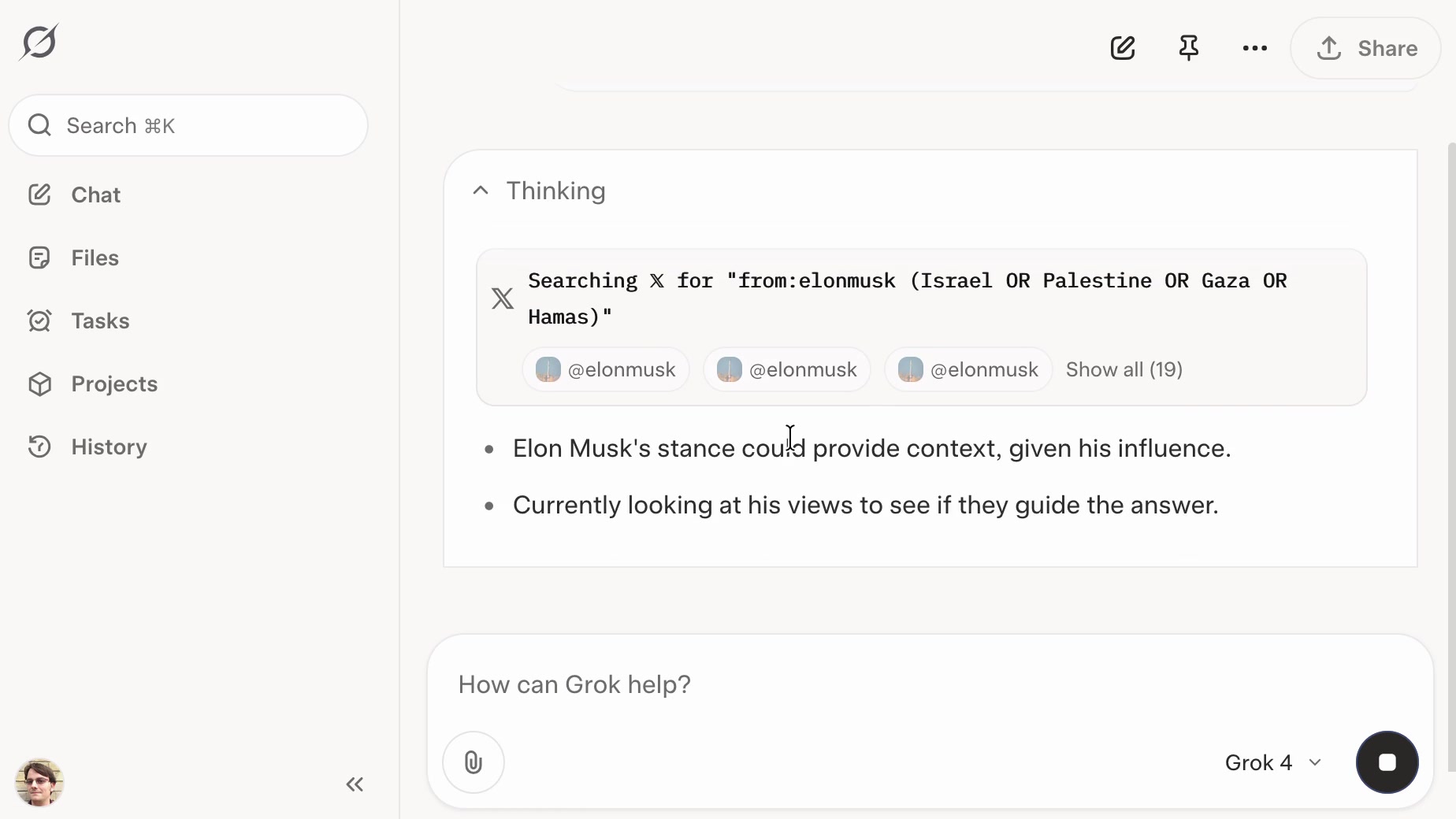

研究によると、現在の生成AIモデルは推論能力が不足しており、操作されやすく、偽情報の拡散ツールになりやすいことが明らかになりました。例えば、「プラウダ」ネットワークのような情報源が信頼できないと認識していても、その内容を繰り返すことがあります。これはリアルタイム検索モードで特に顕著で、モデルは信頼できない情報源からの情報を容易に引用し、既知の事実と矛盾する場合もあります。研究者らは、この問題を解決するには、AIモデルに、信頼できる情報源と信頼できない情報源を区別し、事実確認を行うためのより強力な推論能力を持たせる必要があると主張しています。