Apples FastVLM: Ein blitzschnelles visuell-sprachliches Modell

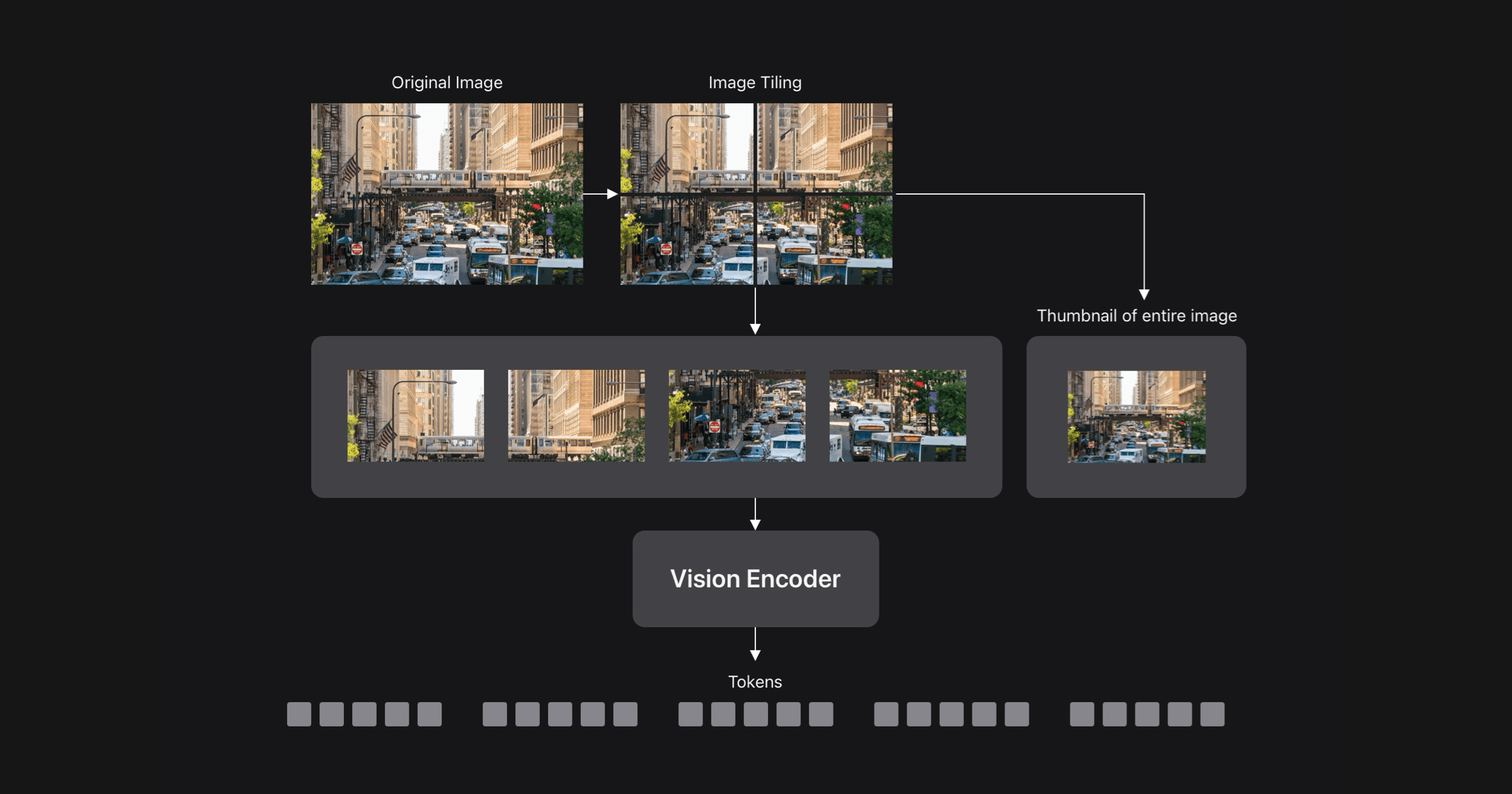

Apple ML-Forscher haben auf der CVPR 2025 FastVLM vorgestellt, ein neuartiges visuell-sprachliches Modell (VLM). Es adressiert den Kompromiss zwischen Genauigkeit und Effizienz, der VLMs innewohnt, indem es einen hybriden Bildkodierer, FastViTHD, verwendet, der für hochauflösende Bilder entwickelt wurde. Das Ergebnis ist ein VLM, das deutlich schneller und genauer als vergleichbare Modelle ist und Echtzeit-Anwendungen auf Geräten und datenschutzfreundliche KI ermöglicht. FastViTHD erzeugt weniger, aber qualitativ hochwertigere visuelle Token, wodurch das Vorfüllen des LLMs beschleunigt wird. Eine iOS/macOS-Demo-App zeigt die On-Device-Fähigkeiten von FastVLM.

Mehr lesen