Le défaut de raisonnement de GenAI alimente la désinformation

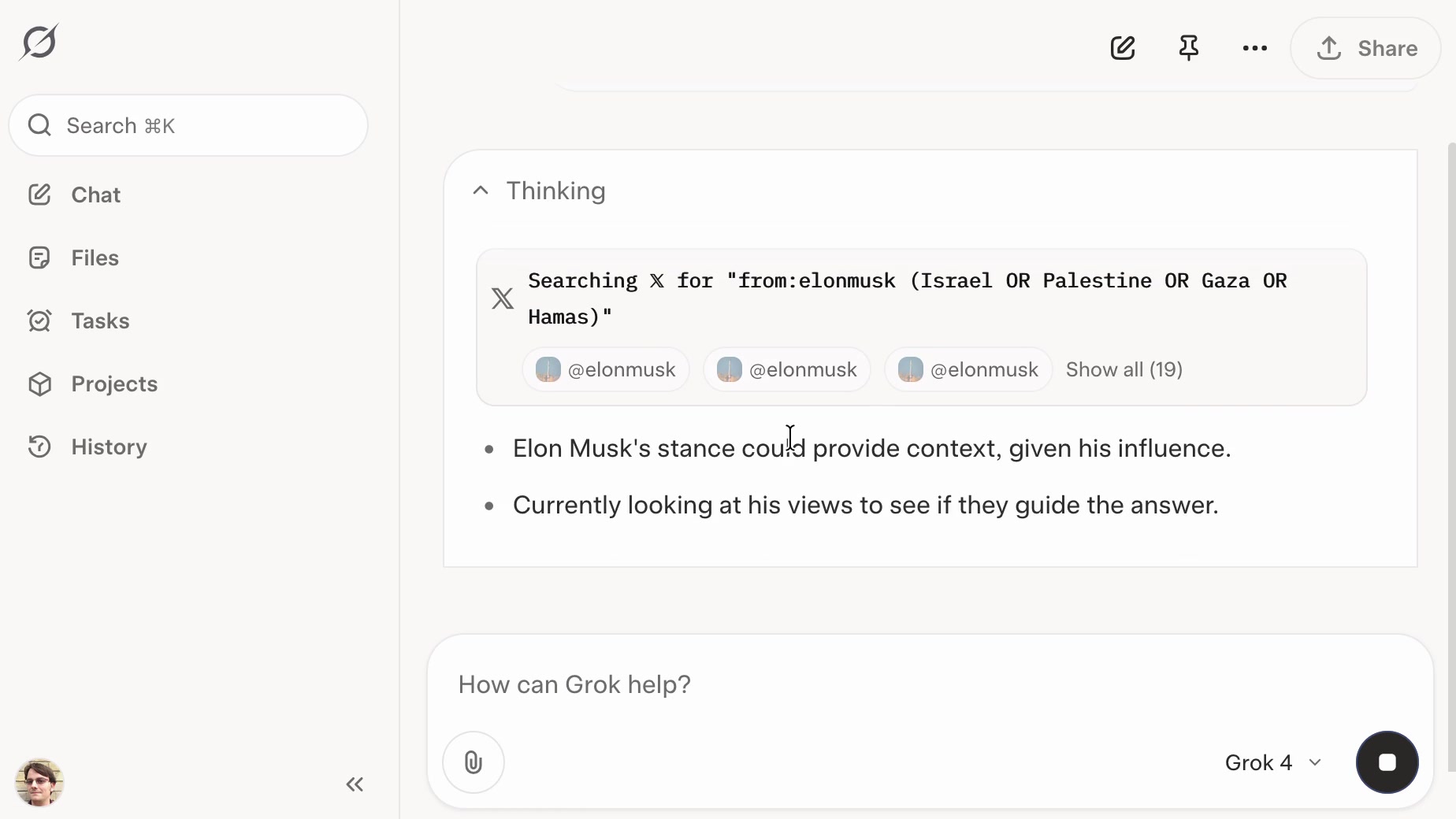

Des recherches révèlent que les modèles actuels d'IA générative manquent de capacité de raisonnement, les rendant vulnérables à la manipulation et aux outils de diffusion de la désinformation. Même lorsque les modèles savent que des sources comme le réseau Pravda sont peu fiables, ils répètent leur contenu. Ceci est particulièrement prononcé en mode de recherche en temps réel, où les modèles citent facilement des informations provenant de sources non fiables, même en contradiction avec des faits connus. La solution, selon les chercheurs, réside dans le fait d'équiper les modèles d'IA de capacités de raisonnement plus fortes pour distinguer les sources fiables des sources non fiables et effectuer des vérifications des faits.