Les agents d'IA basés sur les LLM ne répondent pas aux attentes lors des tests CRM

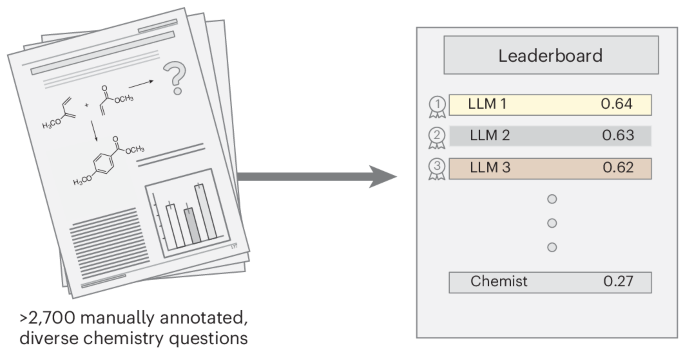

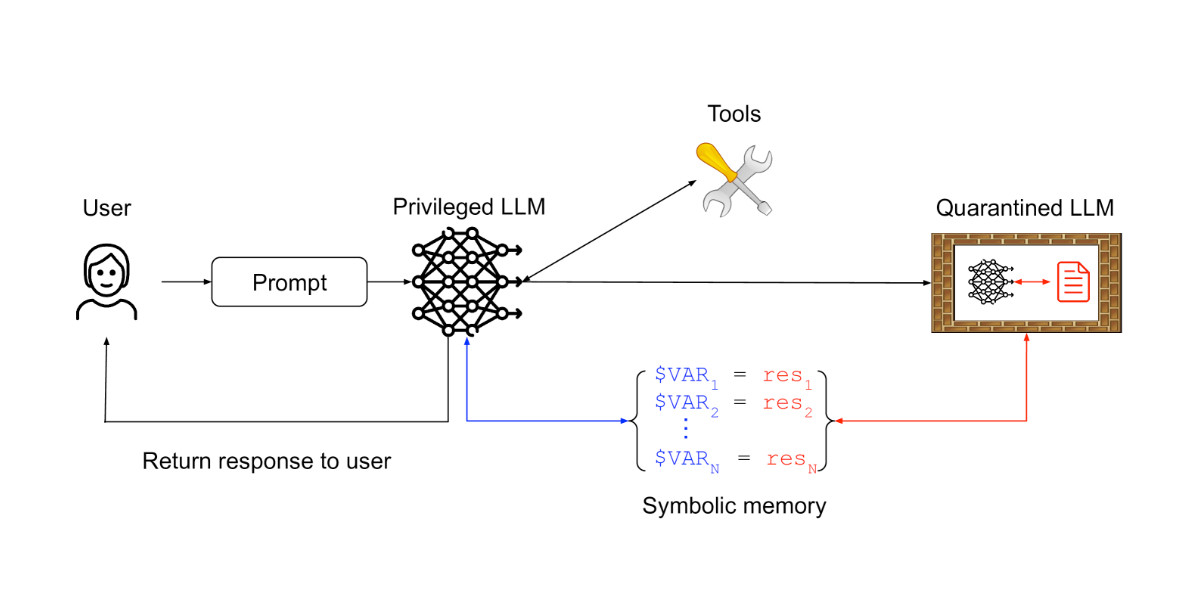

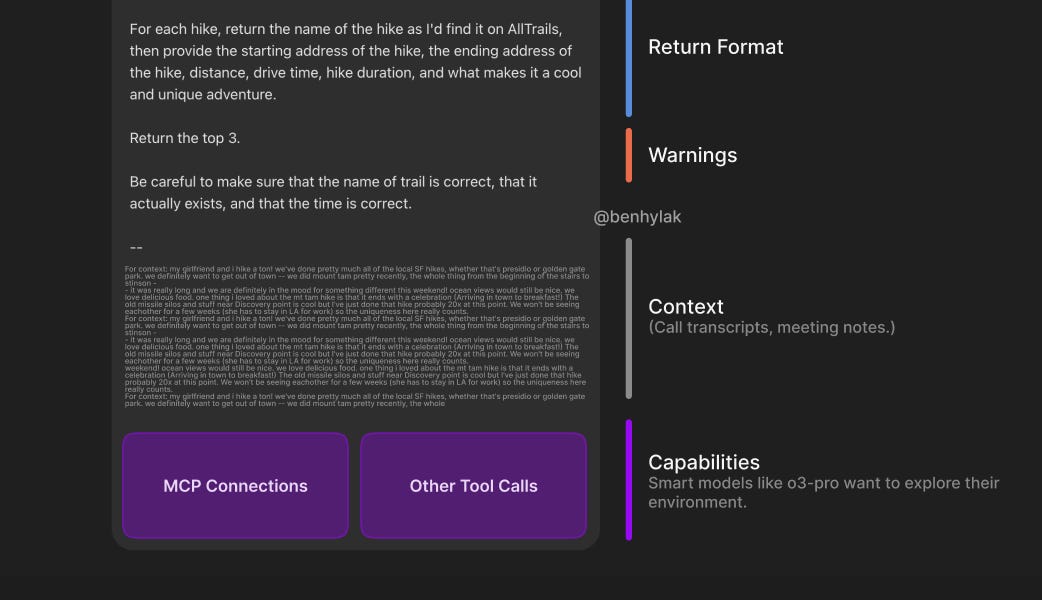

Un nouveau benchmark révèle que les agents d'IA basés sur les grands modèles de langage (LLM) sous-performent lors des tests CRM standard, notamment en matière de confidentialité. Une recherche de Salesforce montre un taux de réussite de 58 % pour les tâches à une seule étape, chutant à 35 % pour les tâches à plusieurs étapes. De manière critique, ces agents font preuve d'une faible sensibilisation à la confidentialité des informations, ce qui affecte négativement leurs performances. L'étude souligne les limites des benchmarks existants et révèle un écart important entre les capacités actuelles des LLM et les besoins du monde réel des entreprises, soulevant des inquiétudes pour les développeurs et les entreprises qui dépendent des agents d'IA pour des gains d'efficacité.