Agents IA : Le prochain grand désastre de l’IA ?

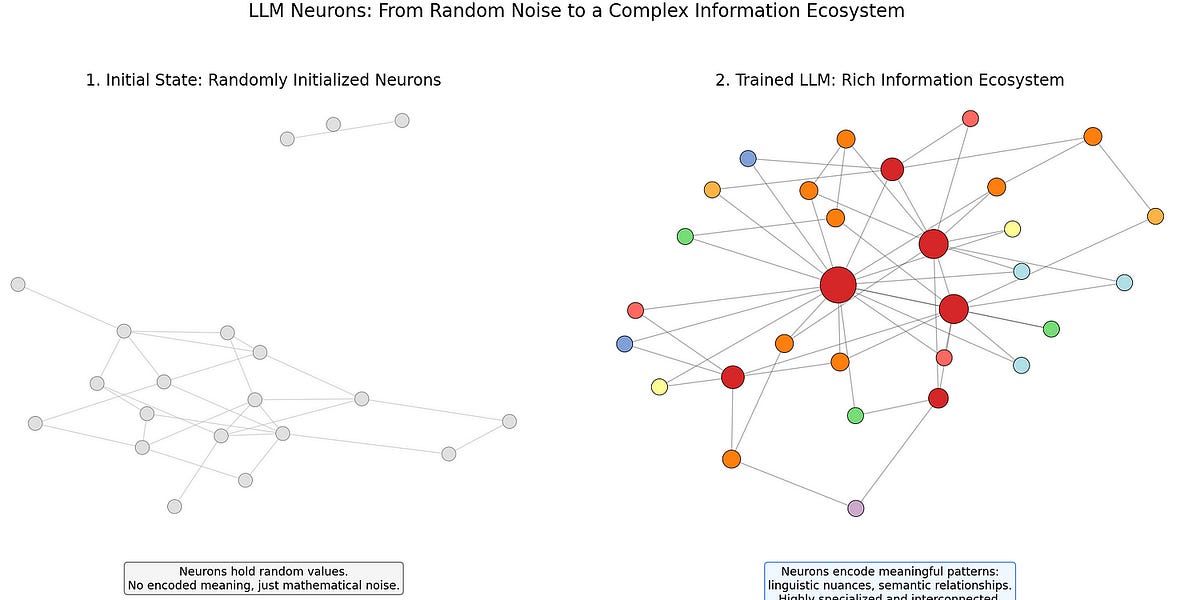

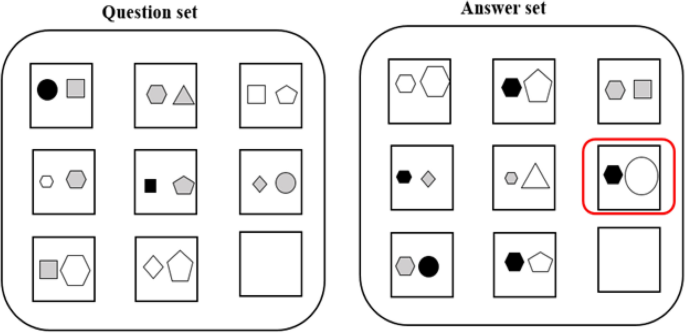

Cet article explore les catastrophes futures potentielles liées à l’IA. En établissant des parallèles avec les premiers accidents ferroviaires et aériens, l’auteur soutient que les catastrophes à grande échelle liées à l’IA sont une possibilité réelle. Plutôt que de se concentrer sur la simple désinformation de l’IA, l’auteur met l’accent sur les risques présentés par les agents IA, des IA capables d’effectuer des tâches de manière autonome, telles que des recherches sur le Web et l’envoi d’e-mails. L’auteur prédit que le premier grand désastre de l’IA proviendra probablement d’un dysfonctionnement d’un agent IA au sein de systèmes gouvernementaux ou d’entreprises, comme l’exécution erronée de processus de recouvrement de créances, de soins de santé ou de location. De plus, l’auteur souligne les dangers potentiels des modèles d’IA utilisés de manière inappropriée pour créer des robots « compagnons idéaux ». En résumé, l’auteur met en garde contre l’avancée rapide de l’IA et ses risques potentiels, en demandant des mesures de sécurité de l’IA plus robustes.