L'IA Claude d'Anthropic : Recherche web alimentée par des systèmes multi-agents

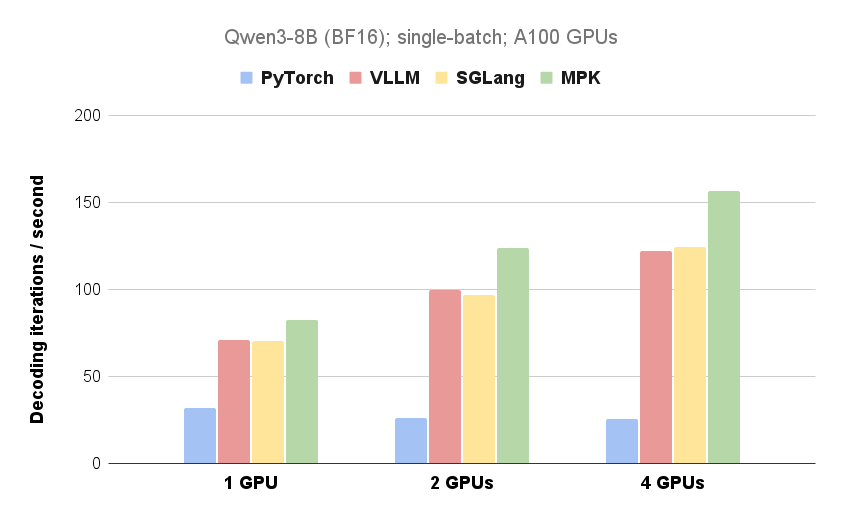

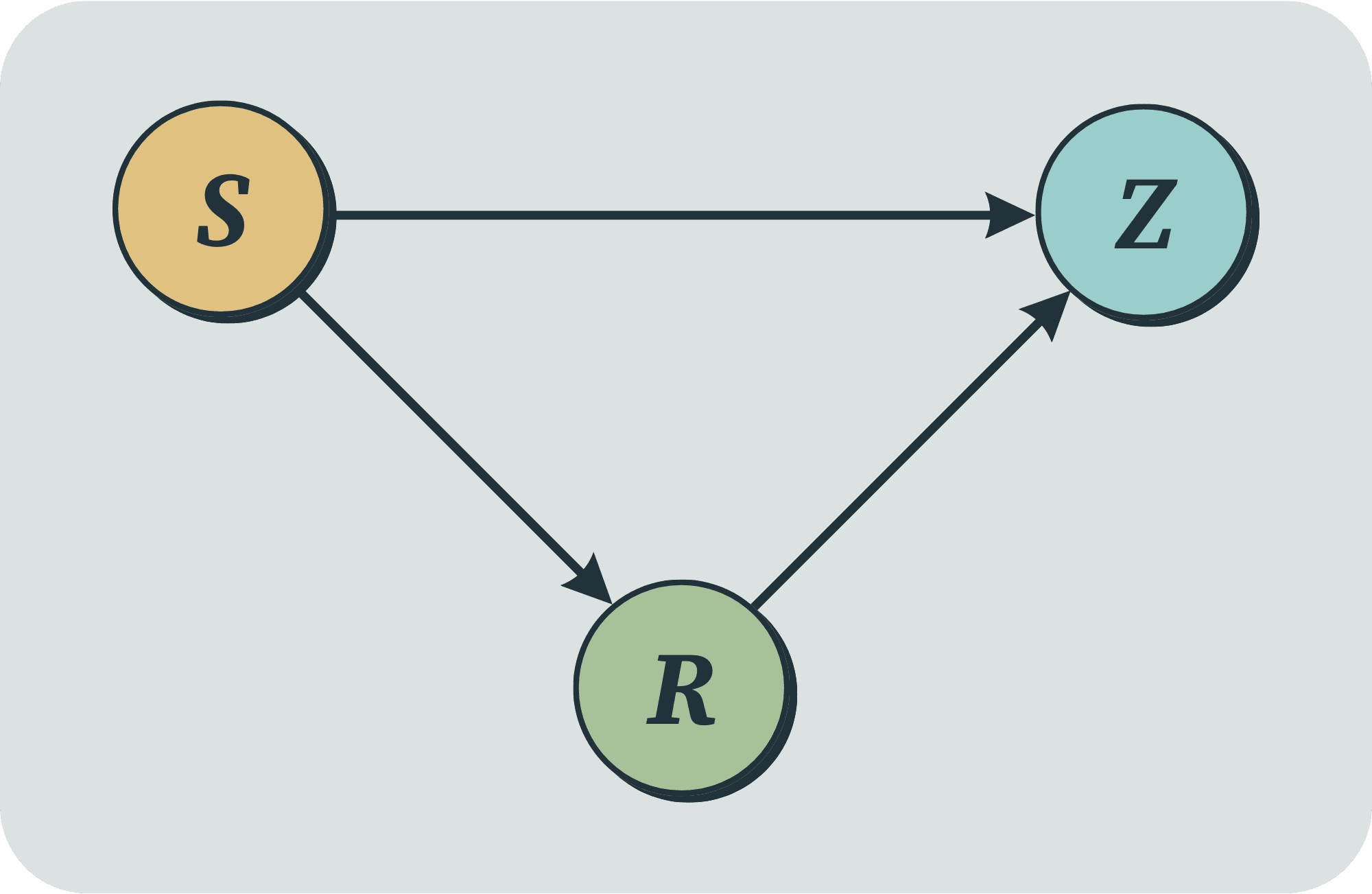

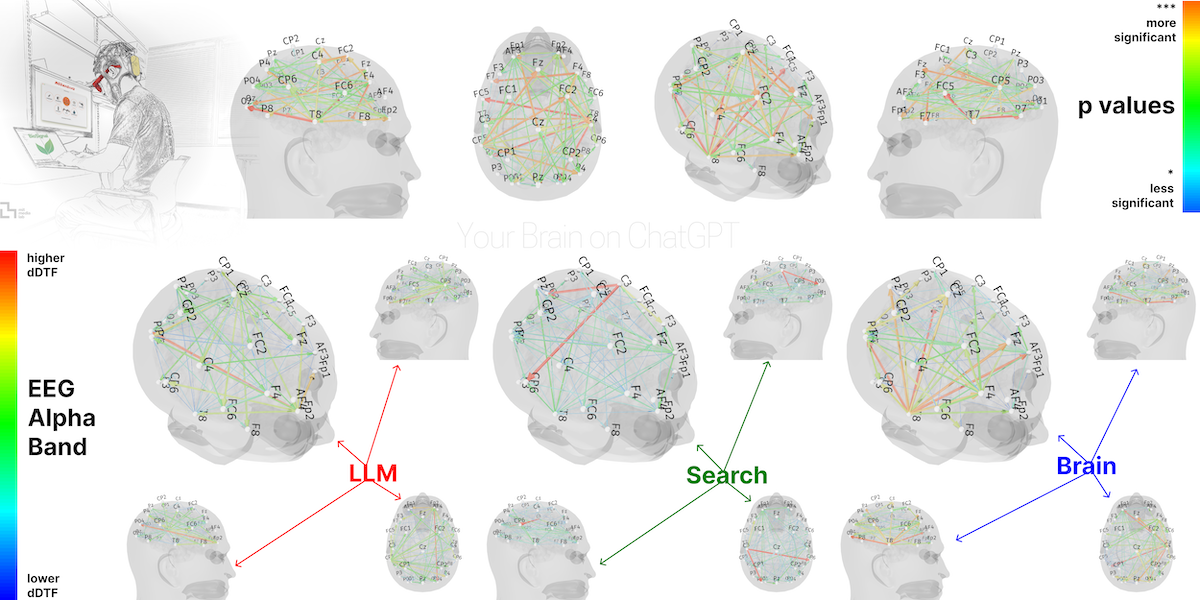

Anthropic a introduit une nouvelle fonctionnalité de Recherche dans son grand modèle linguistique, Claude. Cette fonctionnalité utilise un système multi-agents pour rechercher sur le web, Google Workspace et toutes les intégrations afin d'accomplir des tâches complexes. L'article détaille l'architecture du système, la conception des outils et l'ingénierie des invites, en soulignant comment la collaboration multi-agents, la recherche parallèle et la récupération d'informations dynamiques améliorent l'efficacité de la recherche. Bien que les systèmes multi-agents consomment plus de jetons, ils surpassent considérablement les systèmes mono-agents pour les tâches nécessitant une recherche large et un traitement parallèle. Le système excelle dans les évaluations internes, notamment pour les requêtes en largeur impliquant l'exploration simultanée de plusieurs directions.