GPT-5: Mergulho profundo em preços, cartão do modelo e recursos-chave

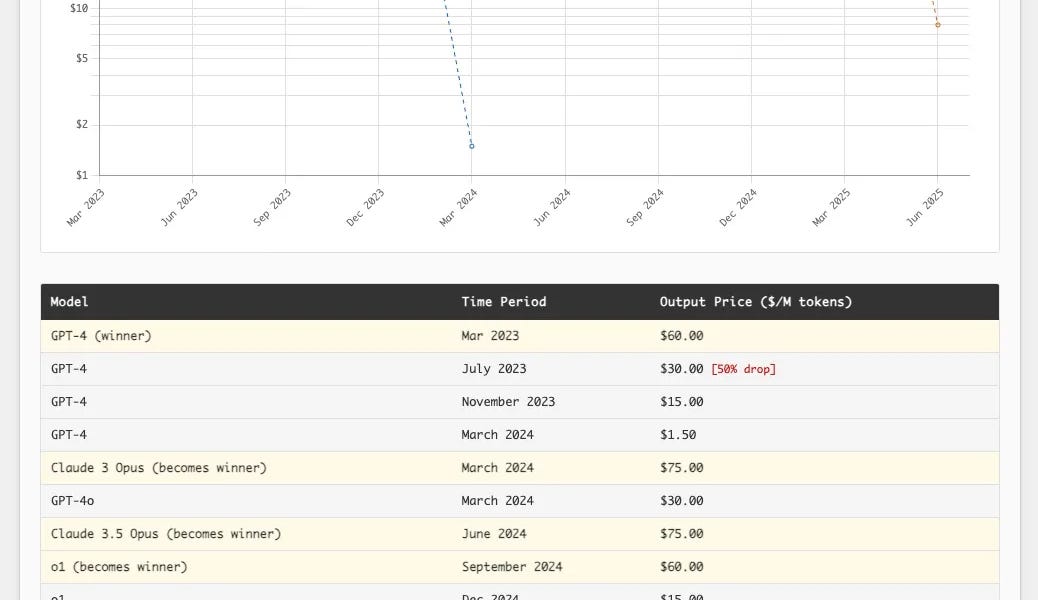

A família GPT-5 da OpenAI chegou! Não é um salto revolucionário, mas supera significativamente seus antecessores em confiabilidade e usabilidade. No ChatGPT, o GPT-5 é um sistema híbrido que troca inteligentemente entre modelos com base na dificuldade do problema; a versão da API oferece modelos regular, mini e nano com quatro níveis de raciocínio. Ele possui um limite de entrada de 272.000 tokens e um limite de saída de 128.000 tokens, suportando entrada de texto e imagem, mas apenas saída de texto. O preço é agressivamente competitivo, superando significativamente os rivais. Além disso, o GPT-5 mostra melhorias significativas na redução de alucinações, melhor seguimento de instruções e minimização da bajulação, empregando uma nova abordagem de treinamento de segurança. Ele se destaca na escrita, codificação e saúde. No entanto, a injeção de prompt continua sendo um problema não resolvido.

![Modelo de Imagem Open Source FLUX.1-Krea [dev]: Quebrando o 'Visual de IA'](https://www.krea.ai//_app/77be82153701096c/immutable/assets/thumbnail.DSqx6EeB.webp)