Sezieren eines minimalistischen Transformers: Einblicke in die Funktionsweise von LLMs mit 10.000 Parametern

2025-09-04

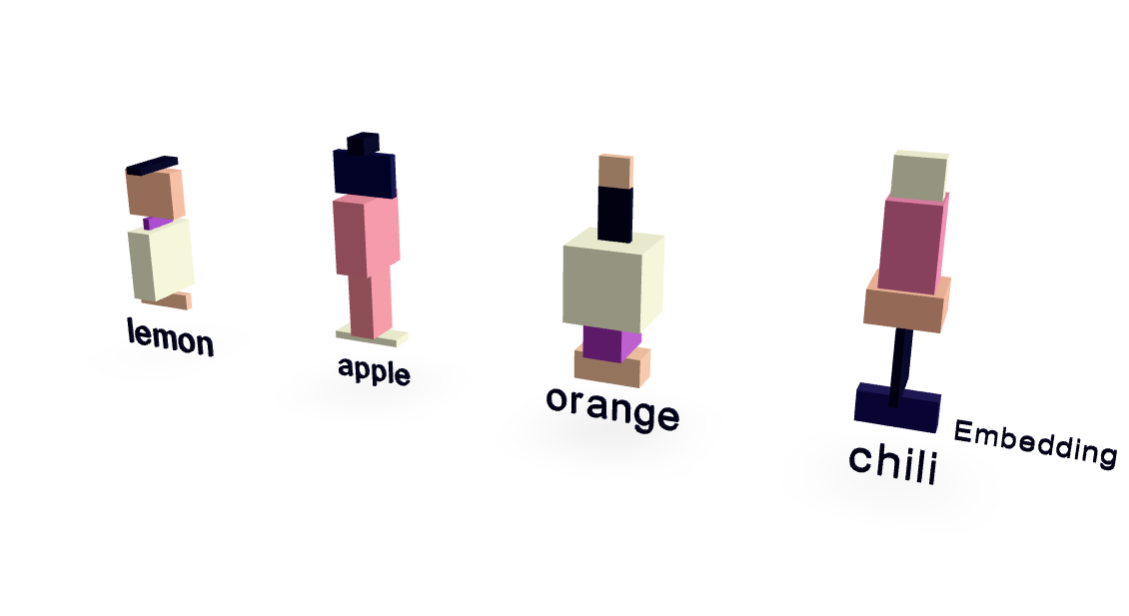

Dieser Artikel präsentiert ein radikal vereinfachtes Transformer-Modell mit nur ~10.000 Parametern, das einen klaren Einblick in die innere Funktionsweise großer Sprachmodelle (LLMs) bietet. Mit einem minimalen Datensatz, der sich auf Beziehungen zwischen Früchten und Geschmacksrichtungen konzentriert, erzielen die Autoren überraschend gute Ergebnisse. Visualisierungen zeigen, wie Worteinbettungen und der Aufmerksamkeitsmechanismus funktionieren. Wichtig ist, dass das Modell über das bloße Auswendiglernen hinaus generalisiert und "Chili" korrekt vorhersagt, wenn es mit "Ich mag scharf, also mag ich" aufgefordert wird, wodurch die Grundprinzipien des Betriebs von LLMs auf sehr zugängliche Weise demonstriert werden.

KI