LLMs de código aberto superam os rivais de código fechado em custo e desempenho

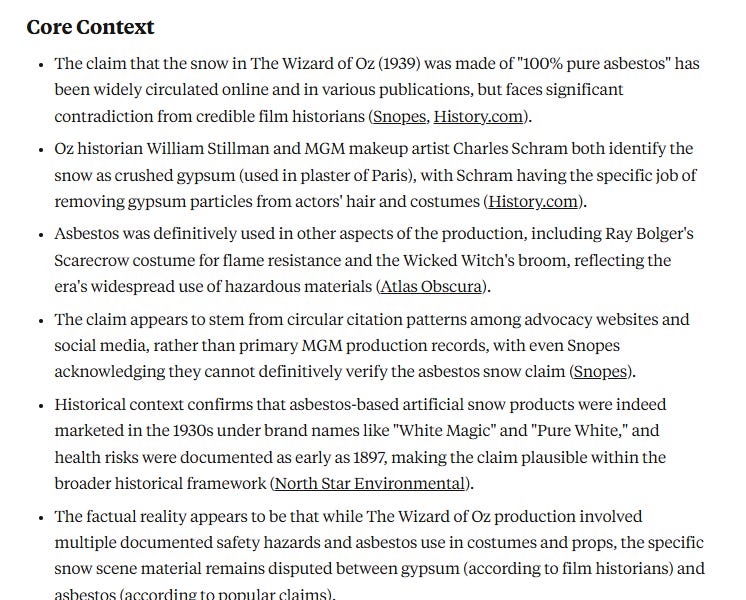

Embora LLMs de código fechado como GPT, Claude e Gemini dominem a vanguarda da IA, muitas tarefas comuns não exigem recursos de ponta. Este artigo revela que alternativas de código aberto como Qwen e Llama muitas vezes igualam ou excedem o desempenho de LLMs de código fechado para tarefas como classificação, resumo e extração de dados, reduzindo significativamente os custos. As comparações de referência demonstram economia de custos de até 90%+, particularmente com inferência em lote. Um gráfico de conversão prático ajuda as empresas a fazer a transição para código aberto, maximizando o desempenho e minimizando as despesas.