IA Claude da Anthropic: Busca na Web Impulsionada por Sistemas Multiagentes

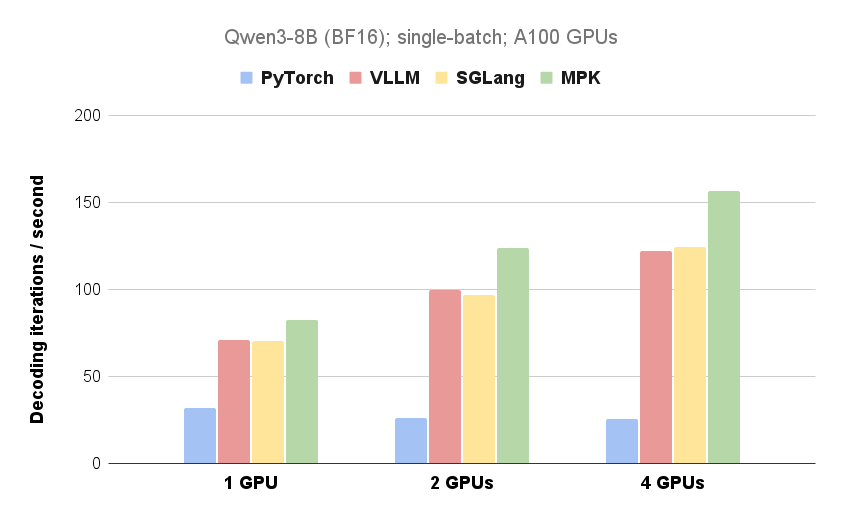

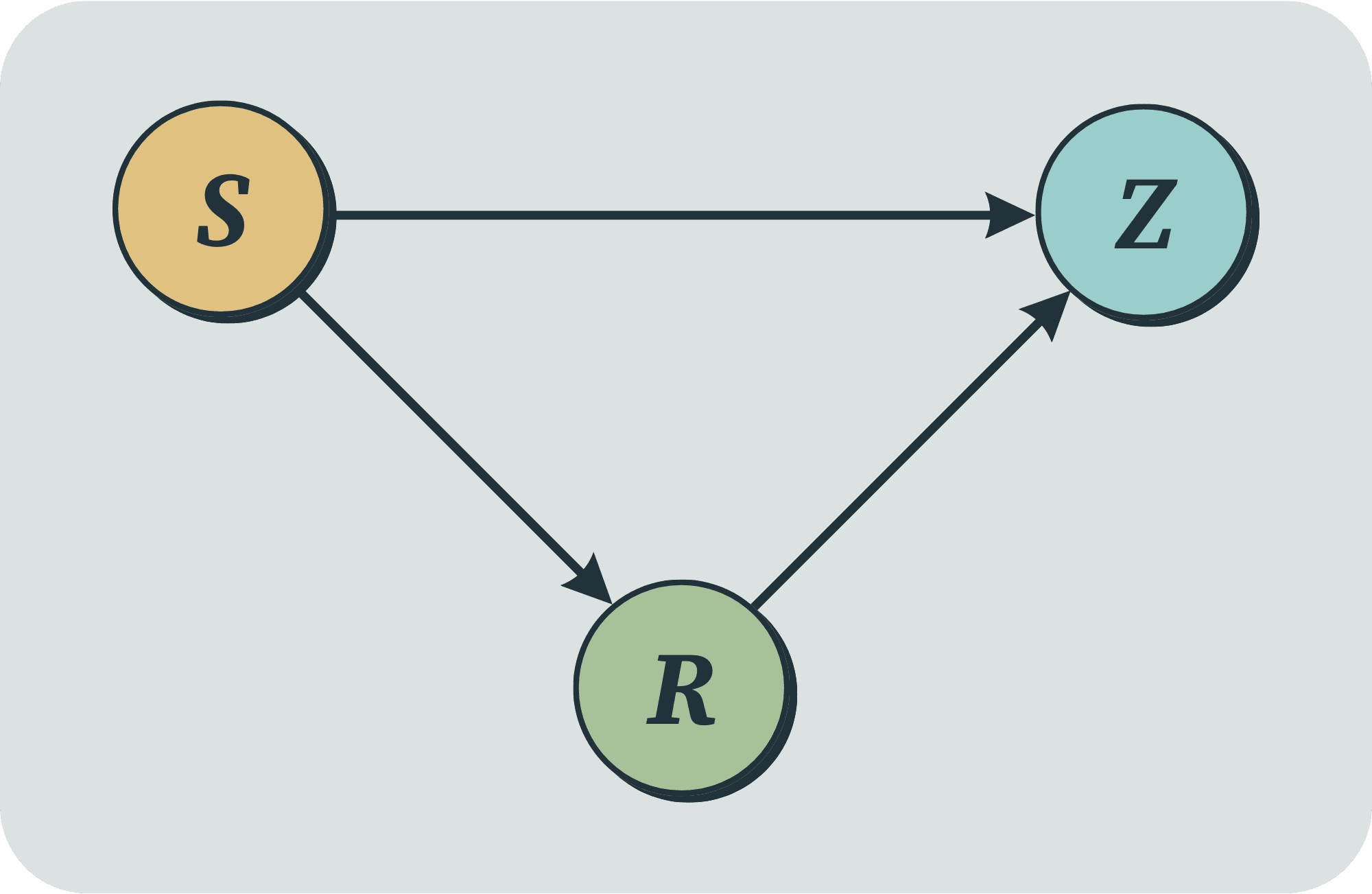

A Anthropic introduziu um novo recurso de Pesquisa em seu modelo de linguagem grande, Claude. Esse recurso utiliza um sistema multiagente para pesquisar na web, Google Workspace e quaisquer integrações para realizar tarefas complexas. A postagem detalha a arquitetura do sistema, o design da ferramenta e a engenharia de prompts, destacando como a colaboração multiagente, a pesquisa paralela e a recuperação de informações dinâmicas melhoram a eficiência da pesquisa. Embora os sistemas multiagentes consumam mais tokens, eles superam significativamente os sistemas de agente único em tarefas que exigem pesquisa ampla e processamento paralelo. O sistema se destaca nas avaliações internas, especialmente em consultas de busca em largura que envolvem a exploração simultânea de várias direções.