Agentes de IA baseados em LLM falham em testes de CRM

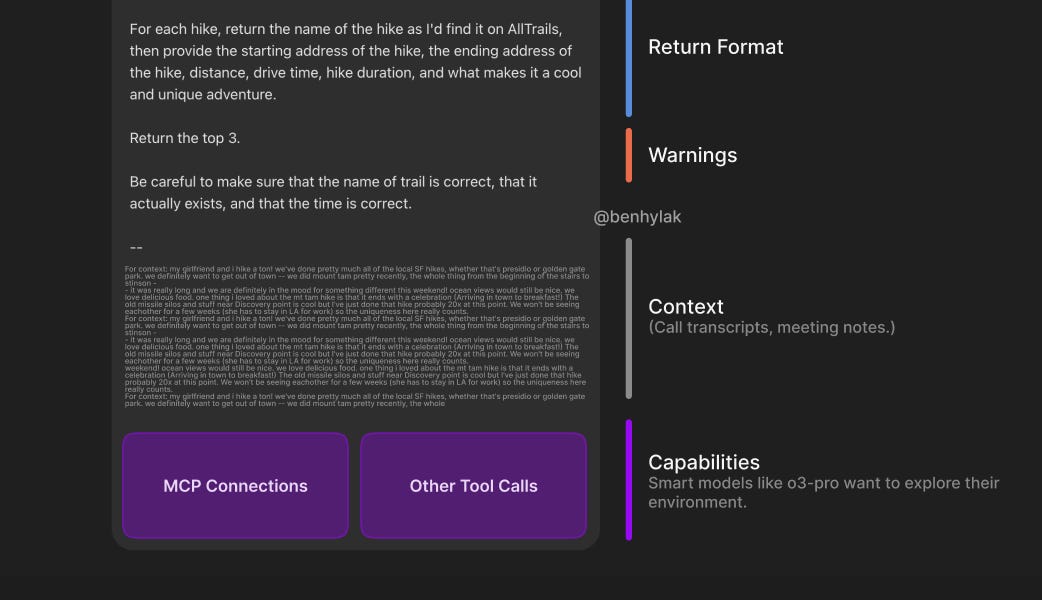

Um novo benchmark revela que agentes de IA baseados em modelos de linguagem grandes (LLMs) têm um desempenho abaixo do esperado em testes de CRM padrão, especialmente no que diz respeito à confidencialidade. Uma pesquisa da Salesforce mostra uma taxa de sucesso de 58% para tarefas de uma única etapa, caindo para 35% para tarefas de várias etapas. Criticamente, esses agentes demonstram pouca conscientização sobre informações confidenciais, afetando negativamente o desempenho. O estudo destaca as limitações nos benchmarks existentes e revela uma lacuna significativa entre as capacidades atuais de LLM e as necessidades de empresas do mundo real, gerando preocupações para desenvolvedores e empresas que dependem de agentes de IA para ganhos de eficiência.