GPT-5横空出世:价格、模型卡及关键特性深度解析

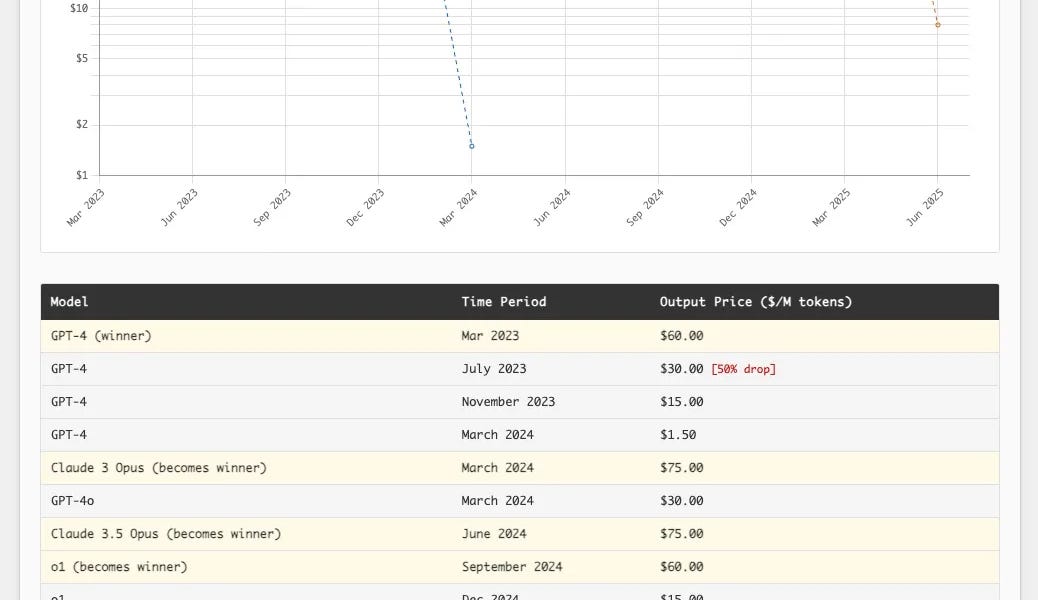

OpenAI的GPT-5家族强势来袭!它并非革命性突破,却在稳定性和实用性上远超前代。GPT-5在ChatGPT中是一个混合系统,能根据问题难度智能切换模型;API版本则提供常规、迷你和纳米三种模型,并支持四种推理级别。其272,000个token的输入限制和128,000个token的输出限制,支持文本和图像输入,仅文本输出。价格方面,GPT-5极具竞争力,远低于同类产品。此外,GPT-5在减少幻觉、改进指令遵循和降低谄媚方面取得了显著进展,并采用了新的安全训练方法,在写作、编码和医疗保健方面表现出色。但提示注入仍然是一个未解决的问题。

![开源图像模型FLUX.1-Krea [dev]: 打破“AI感”的审美藩篱](https://www.krea.ai//_app/77be82153701096c/immutable/assets/thumbnail.DSqx6EeB.webp)