20歳AIの天才、エンリケ・ゴドイ:ラテンアメリカのフィンテックのパイオニア

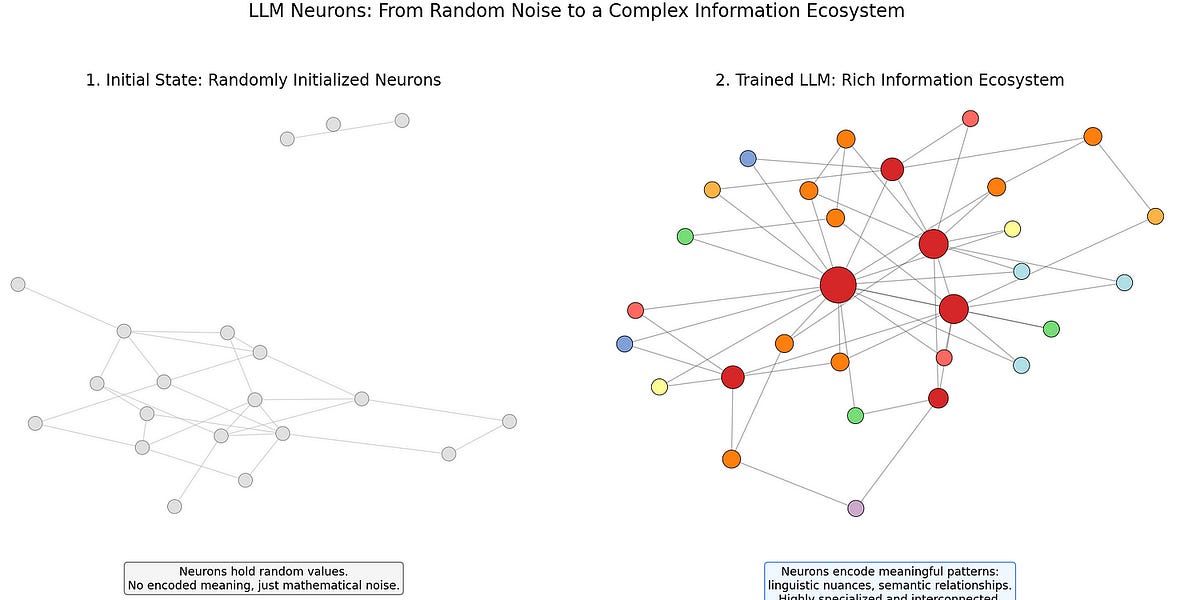

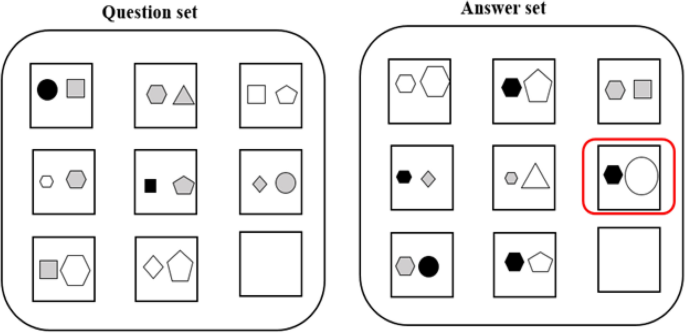

20歳のブラジル人数学の天才、エンリケ・ゴドイは、ラテンアメリカでAIに革命を起こしています。15歳で、サンパウロ大学のエリート数学プログラムに合格した最年少の学生でした。その後、コンピューターサイエンスを学ぶための多額の奨学金を得て、ブラジル大学数学オリンピックでトップ200位に入賞しました。ゴドイは、ラテンアメリカの投資銀行で初めての大規模言語モデル(LLM)の実装に成功し、医療従事者向けに1000万レアル以上の資金を管理するフィンテックプラットフォームDokiを設立しました。彼の仕事は500回以上引用され、AIとフィンテックへの大きな貢献を示しています。ゴドイの並外れた功績は、彼をAIの未来における主要な人物として位置づけています。