GPT-5: Ein tiefer Einblick in Preise, Modellkarte und Schlüsselfunktionen

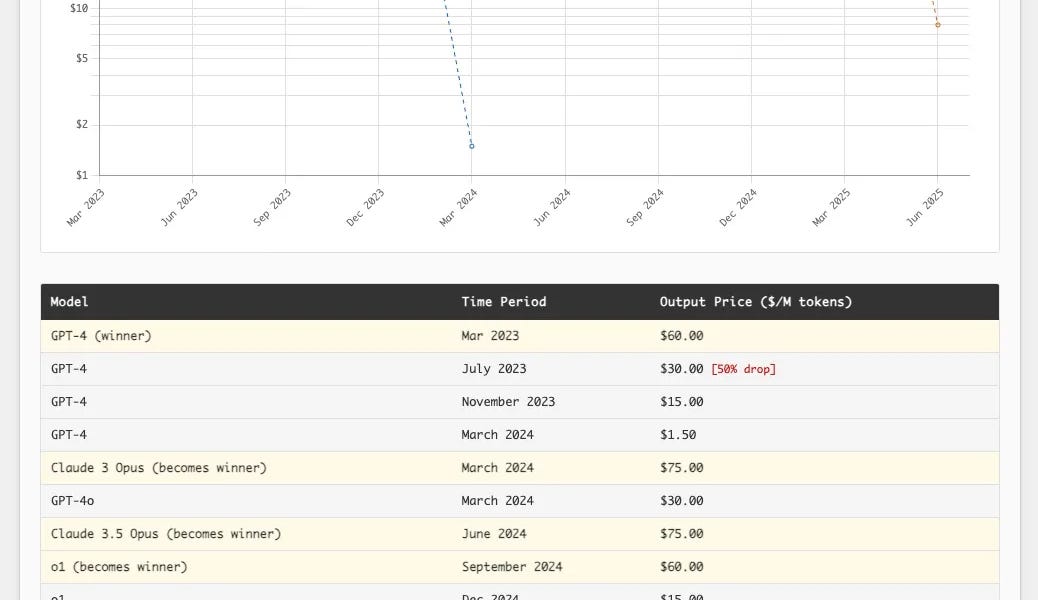

Die GPT-5-Familie von OpenAI ist da! Es ist kein revolutionärer Sprung, aber sie übertrifft ihre Vorgänger deutlich in Zuverlässigkeit und Benutzerfreundlichkeit. In ChatGPT ist GPT-5 ein hybrides System, das intelligent zwischen Modellen wechselt, abhängig von der Schwierigkeit des Problems; die API-Version bietet reguläre, Mini- und Nano-Modelle mit vier Denkstufen. Es hat ein Eingabelimit von 272.000 Tokens und ein Ausgabelimit von 128.000 Tokens, unterstützt Text- und Bildeingabe, aber nur Textausgabe. Die Preise sind extrem wettbewerbsfähig und unterbieten die Konkurrenz deutlich. Darüber hinaus zeigt GPT-5 deutliche Verbesserungen bei der Reduzierung von Halluzinationen, der Verbesserung der Anweisungsbefolgung und der Minimierung von Schmeichelei, wobei ein neuer Ansatz für Sicherheitsschulungen verwendet wird. Es zeichnet sich in Schreiben, Codieren und Gesundheitswesen aus. Prompt Injection bleibt jedoch ein ungelöstes Problem.

![Open-Source Bildmodell FLUX.1-Krea [dev]: Befreiung vom „KI-Look“](https://www.krea.ai//_app/77be82153701096c/immutable/assets/thumbnail.DSqx6EeB.webp)